第一版

第二版

统计学习的主要特点是 :

统计学习以计算机及网络为平台,是建立在计算机及网络之上的;

统计学习以数据为研究对象,是数据驱动的学科;

统计学习的目的是对数据进行预测与分析;

统计学习以方法为中心,统计学习方法构建模型并应用模型进行预测与分析;

统计学习是概率论、统计学、信息论、计算理论、最优化理论及计算机科学等多个领域的交叉学科,并且在发展中逐步形成独自的理论体系与方法论。

假设空间(hypothesis space) :H = { f ( x ; θ ) ∣ θ ∈ R D } o r F = { P ∣ P ( Y ∣ X ; θ ) , θ ∈ R D } \mathcal H = \{ f(x;\theta) | \theta \in \mathbb{R}^D\} \\ or \quad \mathcal F = \{P|P(Y|X;\theta),\theta \in \mathbb{R}^D\} H = { f ( x ; θ ) ∣ θ ∈ R D } or F = { P ∣ P ( Y ∣ X ; θ ) , θ ∈ R D } f ( x ; θ ) f(x; \theta) f ( x ; θ ) θ \theta θ 决策函数 ),也称为模型(Model),参数向量θ \theta θ D D D R D \mathbb{R}^D R D D D D

模型的假设空间(hypothesis space)包含所有可能的条件概率分布或决策函数

特征空间(feature space) :

输入空间中的一个输入向量x = ( x 1 , x 2 ) x = (x_1,x_2) x = ( x 1 , x 2 ) x 1 2 , x 1 x 2 , x 2 2 , . . . x_1^2,x_1x_2,x_2^2,... x 1 2 , x 1 x 2 , x 2 2 , ...

统计学习的三要素 :

模型的假设空间(hypothesis space),简称:模型(model)。假设空间即我们对模型形式的先验假设,最终我们求得的模型必定符合我们对模型形式的先验假设。

模型选择的准则(evaluation criterion),简称:策略(strategy)或者学习准则。即我们用什么标准来评价一个模型的好坏。策略决定了我们从假设空间中选择模型的偏好。

模型学习的算法(algorithm),简称:算法(algorithm)。优化算法指的是通过什么样的方式调整我们的模型结构或模型超参数取值,使得模型的目标函数取值不断降低。优化算法决定了我们用什么样的步骤在假设空间中寻找合适的模型。

以线性回归(Linear Regression)为例:f ( x ; w , b ) = w T x + b f(x;w,b) = w^Tx +b f ( x ; w , b ) = w T x + b L ( y , y ^ ) = ( y − f ( x , θ ) ) 2 \mathcal L(y,\hat{y}) = (y-f(x,\theta))^2 L ( y , y ^ ) = ( y − f ( x , θ ) ) 2

机器学习的定义 :

graph LR;

F(["未知的目标函数(理想中完美的函数):𝑓: 𝒙⟶𝑦"])-->D["训练样本D:{(𝒙¹,𝑦¹),...,(𝒙ⁿ,𝑦ⁿ)}"];

D-->A{{"算法"}}

H{{"假设空间"}}-->A

A-->G["模型 g≈f"]

使用训练数据来计算接近目标 𝑓 的假设(hypothesis )g (来自:Machine Learning Foundations(机器学习基石)- the learning problem,25 页 )

监督学习 :学习输入到输出的映射的统计规律 。

输入变量与输出变量均为连续变量的预测问题称为回归问题 ;分类问题 ;标注问题 (分类问题的推广,如:隐马尔可夫模型 HMM,条件随机场 CRF)。

监督学习的模型可以是概率模型或非概率模型,由条件概率分布 P ( Y ∣ X ) P(Y|X) P ( Y ∣ X ) 决策函数(decision function) Y = f ( X ) Y=f(X) Y = f ( X ) P ( y ∣ x ) P(y|x) P ( y ∣ x ) Y = f ( x ) Y=f(x) Y = f ( x ) y = arg max y P ( y ∣ x ) y =\displaystyle\argmax_{y} P(y|x) y = y arg max P ( y ∣ x )

联合概率分布 :P ( X , Y ) P(X,Y) P ( X , Y ) P ( X , Y ) P(X,Y) P ( X , Y ) 训练数据与测试数据被看作是依联合概率分布P ( X , Y ) P(X,Y) P ( X , Y ) 。X X X Y Y Y

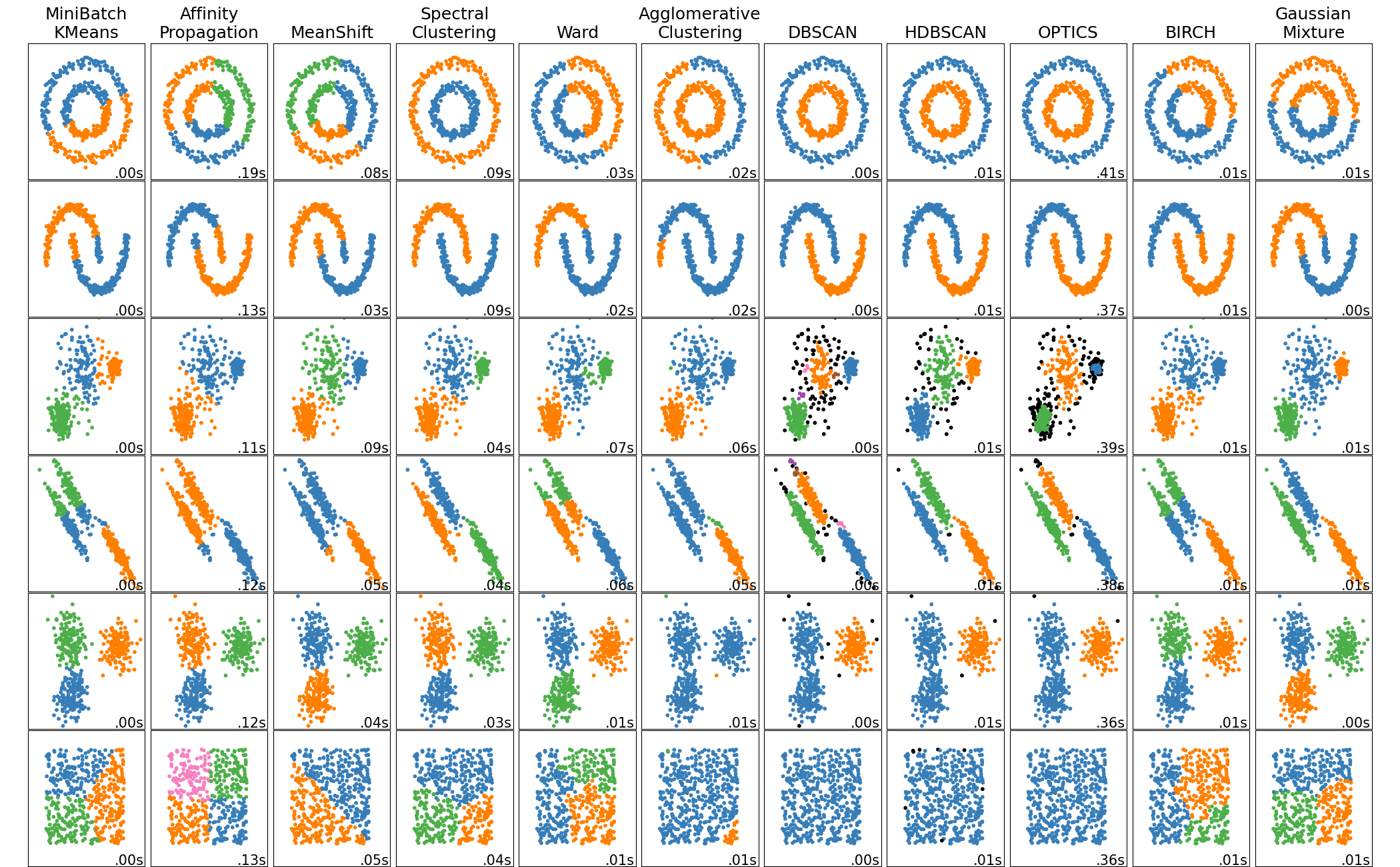

非监督学习 :学习数据中的统计规律或潜在结构 。

非监督学习的模型可以表示为函数z = g ( x ) z = g(x) z = g ( x ) P ( z ∣ x ) P(z|x) P ( z ∣ x ) z z z 聚类 或者降维 )z = arg max z P ( z ∣ x ) z =\displaystyle\argmax_{z} P(z|x) z = z arg max P ( z ∣ x ) P ( x ∣ z ) P(x|z) P ( x ∣ z ) 概率密度估计 ,比如 GMM 中P ( x ∣ z ) P(x|z) P ( x ∣ z ) z z z

核密度估计 Kernel Density Estimation. - 应用密度估计检测离群值(outlier)的LocalOutlierFactor

概率模型(probabilistic model)与非概率模型(non-probabilistic model)或者确定性模型(deterministic model) :

概率模型(probabilistic model)- 条件概率分布 P(y|x)和 非概率模型(non-probabilistic model) - 函数 y=f(x)可以相互转化 ,条件概率分布最大化后得到函数,函数归一化后得到条件概率分布。所以概率模型与非概率模型的区别不在于输入输出之间的映射关系,而在于模型的内部结构:概率模型一定可以表示为联合概率分布的形式,而非概率模型则不一定存在这样的联合概率分布。

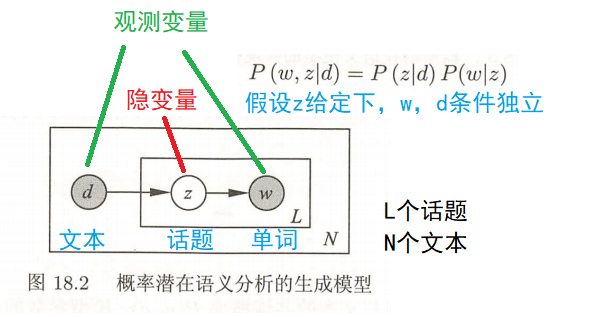

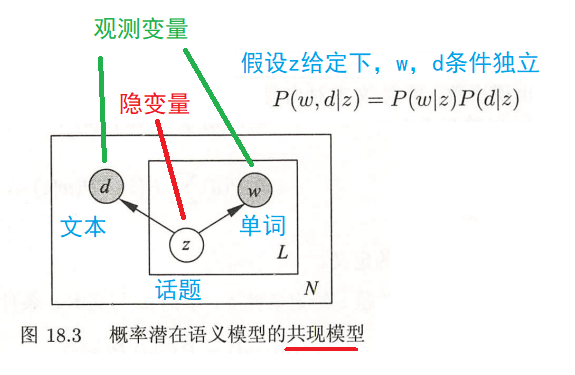

概率模型的代表是概率图模型(probabilistic graphical model) 参考文献 [ 1 − 3 ] ^{参考文献[1-3]} 参考文献 [ 1 − 3 ] P ( x ) = ∑ y P ( x , y ) P ( x , y ) = P ( x ) P ( y ∣ x ) P(x) = \sum_yP(x,y) \\ P(x,y) = P(x)P(y|x) P ( x ) = y ∑ P ( x , y ) P ( x , y ) = P ( x ) P ( y ∣ x )

参数化模型(parametric model)和非参数化模型(non-parametric model) :

参数化模型假设模型参数的维度固定,模型可以由有限维参数完全刻画,不随数据点的变化而变化。(如:感知机、GMM、logistic regression、朴素贝叶斯、k 均值聚类、潜在语义分析、概率潜在语义分析、潜在狄利克雷分配)

非参数化模型意味着决策树没有假设空间分布和分类器结构?

在线学习(online learning)和批量学习(batch learning) :

在线学习每次接受一个样本,预测后学习模型,并不断重复该操作。

在线学习比批量学习更难,因为每次模型更新中可利用的数据有限。

贝叶斯学习(Bayesian learning)/ 贝叶斯推理(Bayesian inference) :B a y e s R u l e : P ( X ∣ Y ) ⏟ p o s t e r i o r = P ( Y ∣ X ) ⏞ l i k e l i h o o d P ( X ) ⏞ p r i o r P ( Y ) ⏟ e v i d e n c e = P ( Y ∣ X ) ⏞ l i k e l i h o o d P ( X ) ⏞ p r i o r ∑ x P ( Y ∣ X ) P ( X ) ⏟ e v i d e n c e \mathrm{Bayes \; Rule:} \\ \underbrace{P(X|Y)}_{\mathrm{posterior}} = \frac{\overbrace{P(Y|X)}^{\mathrm{likelihood}}\overbrace{P(X)}^{\mathrm{prior}}}{\underbrace{P(Y)}_{\mathrm{evidence}}} = \frac{\overbrace{P(Y|X)}^{\mathrm{likelihood}}\overbrace{P(X)}^{\mathrm{prior}}}{\underbrace{\sum_{x}P(Y|X)P(X)}_{\mathrm{evidence}}} Bayes Rule : posterior P ( X ∣ Y ) = evidence P ( Y ) P ( Y ∣ X ) likelihood P ( X ) prior = evidence x ∑ P ( Y ∣ X ) P ( X ) P ( Y ∣ X ) likelihood P ( X ) prior

核技巧(kernel trick)/ 核方法(kernel method) :

核方法 是一类把低维空间的非线性可分问题,转化为高维空间的线性可分问题的方法。核技巧 是一种利用核函数直接计算 ⟨ ϕ ( x ) , ϕ ( z ) ⟩ \lang \phi(x),\phi(z) \rang ⟨ ϕ ( x ) , ϕ ( z )⟩ ϕ ( x ) \phi(x) ϕ ( x ) ϕ ( z ) \phi(z) ϕ ( z )

核函数 :Kernel function X \mathcal X X x i ∈ X x_i \in \mathcal X x i ∈ X X \mathcal X X R n \mathbb R^n R n H \mathcal H H 附加知识 : 各种空间介绍 ^{附加知识:各种空间介绍} 附加知识 : 各种空间介绍 X \mathcal X X H \mathcal H H

ϕ ( x ) : X → H \phi(x) : \mathcal X \to \mathcal H ϕ ( x ) : X → H

使得对所有 x , z ∈ X x,z \in \mathcal X x , z ∈ X K ( x , z ) K(x,z) K ( x , z )

K ( x , z ) = ϕ ( x ) . ϕ ( z ) = ⟨ ϕ ( x ) , ϕ ( z ) ⟩ K(x,z) = \phi(x).\phi(z) = \lang \phi(x),\phi(z) \rang K ( x , z ) = ϕ ( x ) . ϕ ( z ) = ⟨ ϕ ( x ) , ϕ ( z )⟩

则称 K ( x , z ) K(x,z) K ( x , z ) ϕ ( x ) \phi(x) ϕ ( x ) ⟨ ϕ ( x ) , ϕ ( z ) ⟩ \lang \phi(x),\phi(z) \rang ⟨ ϕ ( x ) , ϕ ( z )⟩

核技巧 的想法是,在学习和预测中只定义核函数 K ( x , z ) K(x,z) K ( x , z ) ϕ \phi ϕ K ( x , z ) K(x,z) K ( x , z ) ϕ ( x ) \phi(x) ϕ ( x ) ϕ ( z ) \phi(z) ϕ ( z ) K ( x , z ) K(x,z) K ( x , z )

注意:ϕ \phi ϕ R n \mathbb{R}^n R n H \mathcal H H H \mathcal H H ϕ \phi ϕ 维度灾难 又称维度诅咒(Curse of Dimensionality) 附加知识 : 维度诅咒 ^{附加知识:维度诅咒} 附加知识 : 维度诅咒

正则化符合奥卡姆剃刀(Occam's razor)原理。

参考:L1L2 正则化和凸优化

参考:模型选择

参考:生成模型和判别模型

线性空间 就是定义了加法和数乘 的空间(空间里的一个元素就可以由其他元素线性表示)。

度量空间 就是定义了距离 的空间(曼哈顿距离,欧氏距离,闵可夫斯基距离,马氏距离,切比雪夫距离)。

非负性、同一性:d i s t ( x i , x j ) ≥ 0 dist(x_i,x_j) \geq 0 d i s t ( x i , x j ) ≥ 0 d i s t ( x i , x j ) = 0 dist(x_i,x_j) = 0 d i s t ( x i , x j ) = 0 x i = x j x_i=x_j x i = x j

对称性:d i s t ( x i , x j ) = d i s t ( x j , x i ) dist(x_i,x_j) = dist(x_j,x_i) d i s t ( x i , x j ) = d i s t ( x j , x i )

三角不等式(也叫直递性):d i s t ( x i , x j ) ≤ d i s t ( x i , x k ) + d i s t ( x k , x j ) dist(x_i,x_j) \leq dist(x_i,x_k) + dist(x_k,x_j) d i s t ( x i , x j ) ≤ d i s t ( x i , x k ) + d i s t ( x k , x j )

文字解释:【两点之间距离不为负;两个点只有在 空间 上重合才可能距离为零;a 到 b 的距离等于 b 到 a 的距离;a 到 c 的距离加上 c 到 b 的距离大于等于 a 直接到 b 的距离;】

赋范空间 就是定义了范数 的空间。长度 。那么这里的长度和上一节中说的距离到底有什么区别呢。距离的概念是针对两个元素来说的 ,例如 d(x,y)指的是 x 与 y 两个元素之间的距离,而范数是针对一个元素来说的 ,每一个元素都对应一个范数,可以将范数理解为一个元素到零点的距离(这只是一种理解,并不是定义),也就是它自己的长度。∣ ∣ . ∣ ∣ : R n → R ||.|| : \mathbb{R}^n \to \mathbb{R} ∣∣.∣∣ : R n → R R n \mathbb{R}^n R n

非负性: ∀ x ∈ R n , ∣ ∣ x ∣ ∣ ≥ 0 \forall x \in \mathbb{R}^n ,||x|| \geq 0 ∀ x ∈ R n , ∣∣ x ∣∣ ≥ 0 ∣ ∣ x ∣ ∣ = 0 ||x|| = 0 ∣∣ x ∣∣ = 0 x = 0 x=0 x = 0

数乘:∀ x ∈ R n , a ∈ R n , ∣ ∣ a x ∣ ∣ = ∣ a ∣ . ∣ ∣ x ∣ ∣ \forall x \in \mathbb{R}^n ,a \in \mathbb{R}^n, ||ax|| = |a|.||x|| ∀ x ∈ R n , a ∈ R n , ∣∣ a x ∣∣ = ∣ a ∣.∣∣ x ∣∣

三角不等式: ∀ x , y ∈ R n , ∣ ∣ x + y ∣ ∣ ≤ ∣ ∣ x ∣ ∣ + ∣ ∣ y ∣ ∣ \forall x,y \in \mathbb{R}^n ,||x+y|| \leq ||x|| + ||y|| ∀ x , y ∈ R n , ∣∣ x + y ∣∣ ≤ ∣∣ x ∣∣ + ∣∣ y ∣∣

如果我们定义了范数,可以在这基础上定义距离:dist(x,y)=||x-y||。根据范数的三条性质,我们可以证明我们这样定义的距离也满足距离的定义,聪明的你可以自己证明一下(对称性的证明,提一个-1 出来,一加绝对值就是 1 了)。

也就是说范数其实是一个更加具体的概念,有了范数一定能利用范数定义距离,但是有距离不能定义范数 。

也许你会问,你不是说理解范数就是一个元素到零点的距离吗,那定义范数为||x||=dist(x,0) 不就行了吗。这样的话,对于范数的第二条性质就不一定会满足,||ax||=dist(ax,0),而 dist(ax,0)不一定等于|a|dist(x,0),具体等不等于还要看你的距离是怎么定义的。

例如:Lp 范数p 范数:当 p>=1 时,向量的 Lp 范数是凸的。(这也是为什么一般不用 L0 范数的原因之一)

线性赋范空间 就是定义了加法、数乘和范数的空间。

巴拿赫空间 就是完备的赋范线性空间 。(Banach space)完备的空间 的定义:如果一个空间是完备的,那么该空间中的任何一个柯西序列都收敛在该空间之内。

首先来说一下柯西序列是什么,柯西序列就是随着序数增加,值之间的距离越来越小的序列。换一种说法是,柯西序列可以在去掉有限个值之后,使任意两个值之间的距离 ‾ \underline{\mathrm{距离}} 距离

那么任意一个柯西序列都收敛在该空间内是什么意思呢,举个例子你就明白了。

设定义在有理数空间 Q 上的序列:x n = [ 2 n ] n x_n = \frac{[\sqrt{2}n]}{n} x n = n [ 2 n ] x n x_n x n 2 \sqrt{2} 2

所以完备的意义我们可以这样理解,那就是在一个空间上我们定义了极限,但是不论你怎么取极限,它的极限的值都不会跑出这个空间,那么这个空间就是完备空间 。

另外,不知道你有没有发现,上面在解释什么是柯西序列的时候,有一个词我加了下划线,那就是距离,也就说说在定义完备空间之前,要先有距离的概念。所以完备空间,其实也是完备度量空间 。

所以,巴拿赫空间满足几条特性呢:距离、范数、完备。

内积空间 就是定义了内积的空间。Inner product space

定义映射⟨ . , . ⟩ : V × V → F \lang .,. \rang : V \times V \to \mathbb{F} ⟨ . , . ⟩ : V × V → F V V V F \mathbb{F} F x , y , z ∈ V , s ∈ F x,y,z \in V ,s \in \mathbb{F} x , y , z ∈ V , s ∈ F

第一个参数中的线性:⟨ s x , y ⟩ = s ⟨ x , y ⟩ ⟨ x + y , z ⟩ = ⟨ x , z ⟩ + ⟨ y , z ⟩ ⟨ 0 , x ⟩ = 0 \lang sx,y \rang = s\lang x,y \rang \\ \lang x+y,z \rang = \lang x,z \rang + \lang y,z \rang \\ \lang 0,x \rang = 0 ⟨ s x , y ⟩ = s ⟨ x , y ⟩ ⟨ x + y , z ⟩ = ⟨ x , z ⟩ + ⟨ y , z ⟩ ⟨ 0 , x ⟩ = 0

共轭对称:⟨ x , y ⟩ = ⟨ y , x ⟩ ‾ \lang x,y \rang = \overline{\lang y,x \rang } ⟨ x , y ⟩ = ⟨ y , x ⟩

正定性:⟨ x , x ⟩ > 0 i f x ≠ 0 \lang x,x \rang > 0 \quad\mathrm{if}\; x \neq 0 ⟨ x , x ⟩ > 0 if x = 0

正半定性或非负定性:∀ x , ⟨ x , x ⟩ ≥ 0 \forall{x}, \lang x,x \rang \geq 0 ∀ x , ⟨ x , x ⟩ ≥ 0

确定性:⟨ x , x ⟩ = 0 必然有 x = 0 \lang x,x \rang = 0 必然有 x=0 ⟨ x , x ⟩ = 0 必然有 x = 0

3,4,5 可以跟上面定义范数和距离一样写成一个

例子-欧几里得向量空间:x , y ∈ R n , ⟨ x , y ⟩ = x T y = ∑ _ i = 1 n x i y i x,y \in \mathbb{R}^n , \lang x,y \rang = x^Ty=\sum\_{i=1}^n{x_iy_i} x , y ∈ R n , ⟨ x , y ⟩ = x T y = ∑ _ i = 1 n x i y i

只有定义了内积,才会有夹角的概念,才会有正交的概念,另外内积也可以定义范数,也就是说内积是比范数更具体的一个概念。

欧式空间 就是定义了内积的有限维实线性空间。

希尔伯特空间 就是完备的内积空间。(Hilbert space)

graph LR;

LS(("Linear Space"))-->NLS(("Normed Linear Space"));

NLS-->BS(("Banach Space"))

NLS-->IPS(("Inner Product Space"))

IPS-->HS(("Hilbert Space"))

IPS-->ES(("Euclid Space"))

参考:一片文章带你理解再生核希尔伯特空间(RKHS)以及各种空间

维度诅咒通常是指在涉及到向量的计算的问题中,随着维数的增加,计算量呈指数倍增长的一种现象。高维度有更大的特征空间,需要更多的数据才可以进行较准确的估计。

若特征是二值的,则每增加一个特征,所需数据量都在以 2 的指数级进行增长,更何况很多特征不只是二值的。

几何角度 1:

background

Layer 1

0.5

上图表示一个多维空间(以二维为例),设正方形边长为 1,则其内切圆半径为r = 0.5 r=0.5 r = 0.5 π ( 0.5 ) 2 \pi(0.5)^2 π ( 0.5 ) 2 4 3 π ( 0.5 ) 3 \frac{4}{3}\pi(0.5)^3 3 4 π ( 0.5 ) 3

因此球体的体积可以表示为V ( d ) = π d / 2 Γ ( d 2 + 1 ) 0. 5 d = k ( 0.5 ) d V(d) = \frac{\pi^{d/2}}{\varGamma(\frac{d}{2}+1)}0.5^d = k(0.5)^d V ( d ) = Γ ( 2 d + 1 ) π d /2 0. 5 d = k ( 0.5 ) d lim d → ∞ k ( 0.5 ) d = 0 \lim_{d \to \infty}k(0.5)^d = 0 lim d → ∞ k ( 0.5 ) d = 0 高维情况下,数据大都分布在四角(正方形内,内切圆外) ,稀疏性太大,不好分类。

维度越大,超球体体积越小。说明落在超球体内的样本越少,因为超球体是超立方体的内切球。不在球内,那只能在角落!

几何角度 2:

background

Layer 1

上图也表示一个多维空间(以二维为例),则其中图形的体积有如下关系:外圆半径r = 1 r=1 r = 1 r − ε r−\varepsilon r − ε V 外圆 = k . 1 d = k V_{外圆} = k.1^d = k V 外圆 = k . 1 d = k V 圆环 = k − k ( 1 − ε ) d V_{圆环} = k - k(1-\varepsilon)^d V 圆环 = k − k ( 1 − ε ) d lim d → ∞ V 圆环 V 外圆 = lim d → ∞ k − k ( 1 − ε ) d k = lim d → ∞ ( 1 − ( 1 − ε ) d ) = 1 \lim_{d \to \infty}\frac{V_{圆环}}{V_{外圆}} = \lim_{d \to \infty}\frac{ k - k(1-\varepsilon)^d}{k} = \lim_{d \to \infty}(1-(1-\varepsilon)^d) = 1 d → ∞ lim V 外圆 V 圆环 = d → ∞ lim k k − k ( 1 − ε ) d = d → ∞ lim ( 1 − ( 1 − ε ) d ) = 1

高维情况下,无论ε \varepsilon ε 稀疏 。

参考:The Curse of Dimensionality in classification 机器学习-白板推导系列(五)-降维(Dimensionality Reduction)

所有不等式 以及所有概率(Probabilistic)不等式

由 KL divergence 就能证明D K L ( P ∥ Q ) ≡ ∑ i = 1 n p i log p i q i ≥ 0. {\displaystyle D_{\mathrm {KL} }(P\|Q)\equiv \sum _{i=1}^{n}p_{i}\log {\frac {p_{i}}{q_{i}}}\geq 0.} D KL ( P ∥ Q ) ≡ i = 1 ∑ n p i log q i p i ≥ 0.

柯西-施瓦茨 (Cauchy–Schwarz) 不等式 - Cauchy–Schwarz inequality [ ∑ i = 1 n a i b i ] 2 ≤ [ ∑ i = 1 n a i 2 ] . [ ∑ i = 1 n b i 2 ] 等式成立: b i = k a i 向量形式: ∣ ⟨ u , v ⟩ ∣ ≤ ∣ ∣ u ∣ ∣ . ∣ ∣ v ∣ ∣ 概率中: ∣ E ( X Y ) ∣ 2 ≤ E ( X 2 ) E ( Y 2 ) [\sum_{i=1}^{n}{a_ib_i}]^2 \leq [\sum_{i=1}^{n}a_i^2].[\sum_{i=1}^{n}b_i^2] 等式成立:b_i=ka_i \\ 向量形式:|\braket{u,v}| \leq ||u||.||v|| \\ 概率中:|E(XY)|^2 \leq E(X^2)E(Y^2) [ i = 1 ∑ n a i b i ] 2 ≤ [ i = 1 ∑ n a i 2 ] . [ i = 1 ∑ n b i 2 ] 等式成立: b i = k a i 向量形式: ∣ ⟨ u , v ⟩ ∣ ≤ ∣∣ u ∣∣.∣∣ v ∣∣ 概率中: ∣ E ( X Y ) ∣ 2 ≤ E ( X 2 ) E ( Y 2 ) A ⃗ = ( a 1 , . . . , a n ) , B ⃗ = ( b 1 , . . . , b n ) A ⃗ . B ⃗ = ( a 1 b 1 , . . . , a n b n ) = ∣ ∣ A ⃗ ∣ ∣ . ∣ ∣ B ⃗ ∣ ∣ cos θ ≤ ∣ ∣ A ⃗ ∣ ∣ . ∣ ∣ B ⃗ ∣ ∣ = a 1 2 + . . . + a n 2 . b 1 2 + . . . + b n 2 \vec{A} = (a_1,...,a_n), \vec{B} = (b_1,...,b_n) \\ \vec{A}.\vec{B} = (a_1b_1,...,a_nb_n) = ||\vec{A}||.||\vec{B}||\cos\theta \leq ||\vec{A}||.||\vec{B}|| = \sqrt{a_1^2+...+a_n^2}.\sqrt{b_1^2+...+b_n^2} A = ( a 1 , ... , a n ) , B = ( b 1 , ... , b n ) A . B = ( a 1 b 1 , ... , a n b n ) = ∣∣ A ∣∣.∣∣ B ∣∣ cos θ ≤ ∣∣ A ∣∣.∣∣ B ∣∣ = a 1 2 + ... + a n 2 . b 1 2 + ... + b n 2

证明 covariance inequality:V a r ( Y ) ≥ C o v ( Y , X ) 2 V a r ( X ) Var(Y) \geq \frac{Cov(Y,X)^2}{Var(X)} Va r ( Y ) ≥ Va r ( X ) C o v ( Y , X ) 2 ⟨ X , Y ⟩ : = E ( X Y ) \braket{X,Y} := E(XY) ⟨ X , Y ⟩ := E ( X Y ) ∣ C o v ( Y , X ) ∣ 2 = ∣ E ( ( X − μ ) ( Y − v ) ) ∣ 2 = ∣ ⟨ X − μ , Y − v ⟩ ∣ 2 ≤ ⟨ X − μ , X − μ ⟩ ⟨ Y − v , Y − v ⟩ = E ( ( X − μ ) 2 ) E ( ( Y − v ) 2 ) = V a r ( X ) V a r ( Y ) |Cov(Y,X)|^2 = |E((X-\mu)(Y-v))|^2 = |\braket{X-\mu,Y-v}|^2 \\ \leq \braket{X-\mu,X-\mu}\braket{Y-v,Y-v} = E((X-\mu)^2)E((Y-v)^2) = Var(X)Var(Y) ∣ C o v ( Y , X ) ∣ 2 = ∣ E (( X − μ ) ( Y − v )) ∣ 2 = ∣ ⟨ X − μ , Y − v ⟩ ∣ 2 ≤ ⟨ X − μ , X − μ ⟩ ⟨ Y − v , Y − v ⟩ = E (( X − μ ) 2 ) E (( Y − v ) 2 ) = Va r ( X ) Va r ( Y )

赫尔德 (Holder) 不等式 - Hölder's inequality

琴生 (Jensen) 不等式 - Jensen's inequality f ( t x 1 + ( 1 − t ) x 2 ) ≤ t f ( x 1 ) + ( 1 − t ) f ( x 2 ) , f is convex function 推广: f ( a 1 x 1 + . . . + a n x n ) ≤ a 1 f ( x 1 ) + . . . + a n f ( x n ) , a 1 + . . . + a n = 1 , a i ≥ 0 o r : f ( ∑ i = 1 n a i x i ) ≤ ∑ i = 1 n a i f ( x i ) , ∑ i = 1 n a i = 1 , a i ≥ 0 f(tx_1 +(1-t)x_2) \leq tf(x_1) + (1-t)f(x_2), \text{f is convex function} \\ 推广:f(a_1x_1 +...+ a_nx_n) \leq a_1f(x_1) +...+ a_nf(x_n), a_1+...+a_n = 1 , a_i \geq 0 \\ or: f(\sum_{i=1}^n{a_ix_i}) \leq \sum_{i=1}^n{a_if(x_i)} , \sum_{i=1}^n{a_i} = 1, a_i \geq 0 f ( t x 1 + ( 1 − t ) x 2 ) ≤ t f ( x 1 ) + ( 1 − t ) f ( x 2 ) , f is convex function 推广: f ( a 1 x 1 + ... + a n x n ) ≤ a 1 f ( x 1 ) + ... + a n f ( x n ) , a 1 + ... + a n = 1 , a i ≥ 0 or : f ( i = 1 ∑ n a i x i ) ≤ i = 1 ∑ n a i f ( x i ) , i = 1 ∑ n a i = 1 , a i ≥ 0

概率中:如果X X X φ \varphi φ φ ( E [ X ] ) ≤ E [ φ ( X ) ] \varphi(E[X]) \leq E[\varphi(X)] φ ( E [ X ]) ≤ E [ φ ( X )] E [ φ ( X ) ] − φ ( E [ X ] ) E[\varphi(X)] - \varphi(E[X]) E [ φ ( X )] − φ ( E [ X ])

EM 算法中有用到(log 函数是凹函数正好与凸函数相反);

证明 KL 散度>=0;

马尔可夫不等式 - Markov's inequality P ( X ≥ a ) ≤ E ( X ) a P(X \geq a) \leq \frac{E(X)}{a} P ( X ≥ a ) ≤ a E ( X ) X X X ∀ a > 0 \forall a>0 ∀ a > 0

用于估计一个概率的上界,比如假设你所在公司的人均工资是 1 万,那么随机选一个你司员工,其工资超过 10 万的概率,不会超过 1/10;

用于其他概率不等式的证明,比如霍夫丁不等式;

切比雪夫 (Chebyshev) 不等式 - Chebyshev's inequality P { ∣ X − μ ∣ ≥ k } ≤ σ 2 k 2 P\{|X-\mu| \geq k\} \leq \frac{\sigma^2}{k^2} P { ∣ X − μ ∣ ≥ k } ≤ k 2 σ 2 X X X ∀ k > 0 \forall k>0 ∀ k > 0 μ \mu μ σ 2 \sigma^2 σ 2

霍夫丁不等式 - Hoeffding's inequality

Machine Learning Foundations(机器学习基石)- feasibility of learning,12,13,18 页 统计学习方法,26 页,证明泛化误差上界(在机器学习中常用的几个概率不等式及证明 中也有提到)

参考:初等数学学习笔记

[1-1] Hastie T,Tibshirani R,Friedman J. The Elements of Statistical Learning: DataMining,Inference,and Prediction . Springer. 2001(中译本:统计学习基础——数据挖掘、推理与预测。范明,柴玉梅,昝红英等译。北京:电子工业出版社,2004)

[1-2] Bishop M. Pattern Recognition and Machine Learning . Springer,2006

[1-3] Probabilistic Graphical Models: Principles and Techniques by Daphne Koller, Nir Friedman from The MIT Press

[1-4] Deep Learning (Ian Goodfellow, Yoshua Bengio, Aaron Courville)

[1-5] Tom M Michelle. Machine Learning . McGraw-Hill Companies,Inc. 1997(中译本:机器学习。北京:机械工业出版社,2003)

[1-6] Bayesian Reasoning and Machine Learning by David Barber 2007–2020 ,other version

[1-7] Reinforcement Learning:An Introduction (second edition 2020) by Richard S. Sutton and Andrew G. Barto ,other version

[1-8] 周志华,机器学习 ,清华大学出版社 (手推笔记 以及 公式推导解析 )

[1-9] Lecture Notes in MACHINE LEARNING Dr V N Krishnachandran

判别模型

感知机Perceptron 是神经网络 和支持向量机 的基础。最早在 1957 年由 Rosenblatt 提出参考文献 [ 2 − 1 ] ^{参考文献[2-1]} 参考文献 [ 2 − 1 ] 参考文献 [ 2 − 2 ] ^{参考文献[2-2]} 参考文献 [ 2 − 2 ] 参考文献 [ 2 − 3 ] ^{参考文献[2-3]} 参考文献 [ 2 − 3 ] 参考文献 [ 2 − 4 ] ^{参考文献[2-4]} 参考文献 [ 2 − 4 ] 参考文献 [ 2 − 5 ] ^{参考文献[2-5]} 参考文献 [ 2 − 5 ] 参考文献 [ 2 − 6 ] ^{参考文献[2-6]} 参考文献 [ 2 − 6 ] Brief History of Machine Learning

要求:数据集线性可分(linearly separable data set)

模型 :f ( x ) = s i g n ( w . x + b ) f(x) = sign(w.x + b) f ( x ) = s i g n ( w . x + b ) x , w ∈ R n , b ∈ R x,w \in \mathbb{R}^n ,b \in \mathbb{R} x , w ∈ R n , b ∈ R w w w b b b s i g n ( x ) = { + 1 x ≥ 0 − 1 x < 0 sign(x) = \begin{cases}

+1 & x \geq 0 \\

-1 & x<0

\end{cases} s i g n ( x ) = { + 1 − 1 x ≥ 0 x < 0

感知机是一种线性分类模型,属于判别模型。感知机模型的假设空间是定义在特征空 间中的所有线性分类模型(linear classification model)或线性分类器(linear classifier),即 函数集合{ f ∣ f ( x ) = w ⋅ x + b } \{f|f(x)=w·x+b\} { f ∣ f ( x ) = w ⋅ x + b }

超平面 S:w . x + b = 0 w.x+b = 0 w . x + b = 0 w w w b b b

策略 :L ( w , b ) = − ∑ x i ∈ M y i ( w . x i + b ) L(w,b) = -\sum_{x_i \in M}{y_i(w.x_i + b)} L ( w , b ) = − x i ∈ M ∑ y i ( w . x i + b ) M M M M = { ( x i , y i ) ∣ − y i ( w . x i + b ) > 0 } M = \{ (x_i,y_i)|-y_i(w.x_i +b) > 0\} M = {( x i , y i ) ∣ − y i ( w . x i + b ) > 0 }

函数间隔:y ( w . x + b ) y(w.x + b) y ( w . x + b ) 1 ∣ ∣ w ∣ ∣ ∣ w . x + b ∣ \frac{1}{||w||}|w.x + b| ∣∣ w ∣∣ 1 ∣ w . x + b ∣ 1 ∣ ∣ w ∣ ∣ \frac{1}{||w||} ∣∣ w ∣∣ 1

算法 :min w , b L ( w , b ) = − ∑ x i ∈ M y i ( w . x i + b ) \min_{w,b} L(w,b) = -\sum_{x_i \in M}{y_i(w.x_i + b)} w , b min L ( w , b ) = − x i ∈ M ∑ y i ( w . x i + b ) 随机梯度下降法(stochastic gradient) :

初始化参数(随机法):w 0 , b 0 w_0,b_0 w 0 , b 0

选取数据( x i , y i ) (x_i,y_i) ( x i , y i )

如果( x i , y i ) (x_i,y_i) ( x i , y i ) y i ( w . x i + b ) ≤ 0 y_i(w.x_i + b) \leq 0 y i ( w . x i + b ) ≤ 0 w , b w,b w , b 在 ( x i , y i ) 点处梯度为: ∇ w L ( w , b ) = − y i x i ∇ b L ( w , b ) = − y i 更新 w : w k + 1 ← w k + η y i x i 更新 b : b k + 1 ← b k + η y i 其中学习率 η ∈ ( 0 , 1 ] 在(x_i,y_i)点处梯度为:\\ \nabla_wL(w,b) = -y_ix_i \\ \nabla_bL(w,b) = -y_i\\ 更新w:w_{k+1} \gets w_{k}+\eta y_ix_i \\ 更新b:b_{k+1} \gets b_{k}+\eta y_i \\其中学习率\eta \in (0,1] 在 ( x i , y i ) 点处梯度为: ∇ w L ( w , b ) = − y i x i ∇ b L ( w , b ) = − y i 更新 w : w k + 1 ← w k + η y i x i 更新 b : b k + 1 ← b k + η y i 其中学习率 η ∈ ( 0 , 1 ]

循环 2-3,直到训练集中没有误分类点。

Novikoff 定理:T = { ( x 1 , y 1 ) , . . . , ( x N , y N ) } T = \{(x_1,y_1),...,(x_N,y_N)\} T = {( x 1 , y 1 ) , ... , ( x N , y N )}

设完美超平面w ^ o p t . x ^ = 0 , ∣ ∣ w ^ o p t ∣ ∣ = 1 \hat{w}_{opt}.\hat{x} = 0 , ||\hat{w}_{opt}||=1 w ^ o pt . x ^ = 0 , ∣∣ w ^ o pt ∣∣ = 1 w ^ o p t . x ^ = w o p t . x + b \hat{w}_{opt}.\hat{x} = w_{opt}.x +b w ^ o pt . x ^ = w o pt . x + b γ > 0 \gamma >0 γ > 0 y i ( w ^ o p t . x i ^ ) ≥ γ y_i(\hat{w}_{opt}.\hat{x_i}) \geq \gamma y i ( w ^ o pt . x i ^ ) ≥ γ

令R = max 1 ≤ i ≤ N ∣ ∣ x i ^ ∣ ∣ R = \max_{1\leq i\leq N}||\hat{x_i}|| R = max 1 ≤ i ≤ N ∣∣ x i ^ ∣∣ k ≤ ( R γ ) 2 k \leq (\frac{R}{\gamma})^2 k ≤ ( γ R ) 2

证明(注意:带 hat 的表示扩充向量):

因为数据线性可分,对于所有点y i ( w ^ o p t . x i ^ ) > 0 y_i(\hat{w}_{opt}.\hat{x_i}) > 0 y i ( w ^ o pt . x i ^ ) > 0 γ = min i y i ( w ^ o p t . x i ^ ) ≤ y i ( w ^ o p t . x i ^ ) (2-1) \gamma = \min_i{y_i(\hat{w}_{opt}.\hat{x_i})} \leq {y_i(\hat{w}_{opt}.\hat{x_i})} \label{2-1}\tag{2-1} γ = i min y i ( w ^ o pt . x i ^ ) ≤ y i ( w ^ o pt . x i ^ ) ( 2-1 ) γ \gamma γ

为了方便计算 设 扩充向量w ^ = ( w T , b ) T \hat{w} = (w^T,b)^T w ^ = ( w T , b ) T w ^ k = w ^ k − 1 + η y i x i ^ (2-2) \hat{w}_{k} = \hat{w}_{k-1}+\eta y_i\hat{x_i} \label{2-2}\tag{2-2} w ^ k = w ^ k − 1 + η y i x i ^ ( 2-2 )

推导不等式w ^ k . w ^ o p t ≥ k η γ (2-3) \hat{w}_{k}.\hat{w}_{opt} \geq k\eta\gamma \label{2-3}\tag{2-3} w ^ k . w ^ o pt ≥ k η γ ( 2-3 )

由( 2-1 ) \eqref{2-1} ( 2-1 ) ( 2-2 ) \eqref{2-2} ( 2-2 ) w ^ k . w ^ o p t = w ^ k − 1 . w ^ o p t + η y i w ^ o p t . x i ^ ≥ w ^ k − 1 . w ^ o p t + η γ ≥ w ^ k − 2 . w ^ o p t + 2 η γ ≥ k η γ \hat{w}_{k}.\hat{w}_{opt} = \hat{w}_{k-1}.\hat{w}_{opt} + \eta{y_i}\hat{w}_{opt}.\hat{x_i} \\ \geq \hat{w}_{k-1}.\hat{w}_{opt} + \eta\gamma \\ \geq \hat{w}_{k-2}.\hat{w}_{opt} + 2\eta\gamma \\ \geq k\eta\gamma w ^ k . w ^ o pt = w ^ k − 1 . w ^ o pt + η y i w ^ o pt . x i ^ ≥ w ^ k − 1 . w ^ o pt + η γ ≥ w ^ k − 2 . w ^ o pt + 2 η γ ≥ k η γ

推导不等式∣ ∣ w ^ k ∣ ∣ 2 ≤ k η 2 R 2 (2-4) ||\hat{w}_{k}||^2 \leq k\eta^2R^2 \label{2-4}\tag{2-4} ∣∣ w ^ k ∣ ∣ 2 ≤ k η 2 R 2 ( 2-4 ) ( 2-2 ) \eqref{2-2} ( 2-2 ) ∣ ∣ w ^ k ∣ ∣ 2 = ∣ ∣ w ^ k − 1 + η y i x i ^ ∣ ∣ 2 = ∣ ∣ w ^ k − 1 ∣ ∣ 2 + 2 η y i w ^ k − 1 . x ^ i + η 2 ∣ ∣ x ^ i ∣ ∣ 2 ||\hat{w}_{k}||^2=||\hat{w}_{k-1}+\eta y_i\hat{x_i}||^2 = ||\hat{w}_{k-1}||^2 + 2\eta{y_i}\hat{w}_{k-1}.\hat{x}_{i} + \eta^2||\hat{x}_{i}||^2 ∣∣ w ^ k ∣ ∣ 2 = ∣∣ w ^ k − 1 + η y i x i ^ ∣ ∣ 2 = ∣∣ w ^ k − 1 ∣ ∣ 2 + 2 η y i w ^ k − 1 . x ^ i + η 2 ∣∣ x ^ i ∣ ∣ 2 y i w ^ k − 1 . x ^ i ≤ 0 {y_i}\hat{w}_{k-1}.\hat{x}_{i} \leq 0 y i w ^ k − 1 . x ^ i ≤ 0 ∣ ∣ w ^ k ∣ ∣ 2 = ∣ ∣ w ^ k − 1 ∣ ∣ 2 + 2 η y i w ^ k − 1 . x ^ i + η 2 ∣ ∣ x ^ i ∣ ∣ 2 ≤ ∣ ∣ w ^ k − 1 ∣ ∣ 2 + η 2 ∣ ∣ x ^ i ∣ ∣ 2 ≤ ∣ ∣ w ^ k − 1 ∣ ∣ 2 + η 2 R 2 ≤ ∣ ∣ w ^ k − 2 ∣ ∣ 2 + 2 η 2 R 2 ≤ . . . ≤ k η 2 R 2 ||\hat{w}_{k}||^2 =||\hat{w}_{k-1}||^2 + 2\eta{y_i}\hat{w}_{k-1}.\hat{x}_{i} + \eta^2||\hat{x}_{i}||^2 \\ \leq ||\hat{w}_{k-1}||^2 + \eta^2||\hat{x}_{i}||^2 \\ \leq ||\hat{w}_{k-1}||^2 + \eta^2R^2 \\ \leq ||\hat{w}_{k-2}||^2 + 2\eta^2R^2 \leq ... \\ \leq k\eta^2R^2 ∣∣ w ^ k ∣ ∣ 2 = ∣∣ w ^ k − 1 ∣ ∣ 2 + 2 η y i w ^ k − 1 . x ^ i + η 2 ∣∣ x ^ i ∣ ∣ 2 ≤ ∣∣ w ^ k − 1 ∣ ∣ 2 + η 2 ∣∣ x ^ i ∣ ∣ 2 ≤ ∣∣ w ^ k − 1 ∣ ∣ 2 + η 2 R 2 ≤ ∣∣ w ^ k − 2 ∣ ∣ 2 + 2 η 2 R 2 ≤ ... ≤ k η 2 R 2

由( 2-3 ) \eqref{2-3} ( 2-3 ) ( 2-4 ) \eqref{2-4} ( 2-4 )

k η γ ≤ w ^ k . w ^ o p t ≤ ∣ ∣ w ^ k ∣ ∣ . ∣ ∣ w ^ o p t ∣ ∣ ⏟ = 1 ⏟ 柯西-施瓦茨 (Cauchy–Schwarz) 不等式 ≤ k η R ⇒ k 2 γ 2 ≤ k R 2 ⇒ k ≤ ( R γ ) 2 k\eta\gamma \leq \underbrace{\hat{w}_{k}.\hat{w}_{opt} \leq ||\hat{w}_{k}||.\underbrace{||\hat{w}_{opt}||}_{=1} }_{\text{柯西-施瓦茨 (Cauchy–Schwarz) 不等式}} \leq \sqrt{k} \eta R \\ \; \\ \Rightarrow k^2\gamma^2 \leq kR^2 \\ \Rightarrow k \leq (\frac{R}{\gamma})^2 k η γ ≤ 柯西 - 施瓦茨 (Cauchy–Schwarz) 不等式 w ^ k . w ^ o pt ≤ ∣∣ w ^ k ∣∣. = 1 ∣∣ w ^ o pt ∣∣ ≤ k η R ⇒ k 2 γ 2 ≤ k R 2 ⇒ k ≤ ( γ R ) 2

也就是说 k 是有上界的。

书中还介绍了原形式的对偶形式 ,也就是等价形式(SVM 中 7.2.2 节 127 页也是等价的意思,区别于拉格朗日对偶),这两个地方的等价都是经过基本推导,求出 w 参数,然后对原问题进行了替换。

[2-1] Rosenblatt, F. (1958). The perceptron: A probabilistic model for information storage and organization in the brain . Psychological Review, 65(6), 386–408.

[2-2] Novikoff, A. B. (1962). On convergence proofs on perceptrons. Symposium on the Mathematical Theory of Automata, 12, 615-622. Polytechnic Institute of Brooklyn.

[2-3] Minsky M L and Papert S A 1969 Perceptrons (Cambridge, MA: MIT Press)

[2-4] Gallant, S. I. (1990). Perceptron-based learning algorithms. IEEE Transactions on Neural Networks, vol. 1, no. 2, pp. 179-191.

[2-5] Freund, Y. and Schapire, R. E. 1998. Large margin classification using the perceptron algorithm. In Proceedings of the 11th Annual Conference on Computational Learning Theory (COLT' 98). ACM Press.

[2-6] Li YY,Zaragoza H,Herbrich R,Shawe-Taylor J,Kandola J. The Perceptron algorithmwith uneven margins. In: Proceedings of the 19th International Conference on MachineLearning. 2002,379–386

[2-7] Widrow, B. , Lehr, M.A., "30 years of Adaptive Neural Networks: Perceptron, Madaline, and Backpropagation, " Proc. IEEE, vol 78, no 9, pp. 1415-1442, (1990)。

[2-8] Cristianini N,Shawe-Taylor J. An Introduction to Support Vector Machines and OtherKernelbased Learning Methods. Cambridge University Press,2000

判别模型

k 近邻法(k-nearest neighbor,k-NN )1968 年由 Cover 和 Hart 提出,是一种基本分类与回归方法。本书只讨论分类问题中的 k 近邻法。

k 近邻法的三个基本要素 :L 2 L_2 L 2 L p L_p L p

模型 :

策略 :y = arg min c j 1 k ∑ x i ∈ N k ( x ) I ( y i ≠ c j ) = 1 − 1 k ∑ x i ∈ N k ( x ) I ( y i = c j ) y = \argmin_{c_j} \frac{1}{k} \sum_{x_i \in N_k(x)} I(y_i \neq c_j) = 1- \frac{1}{k}\sum_{x_i \in N_k(x)} I(y_i = c_j) y = c j arg min k 1 x i ∈ N k ( x ) ∑ I ( y i = c j ) = 1 − k 1 x i ∈ N k ( x ) ∑ I ( y i = c j ) c j c_j c j 1 k ∑ x i ∈ N k ( x ) I ( y i = c j ) \frac{1}{k}\sum_{x_i \in N_k(x)} I(y_i = c_j) k 1 ∑ x i ∈ N k ( x ) I ( y i = c j ) 1 k ∑ x i ∈ N k ( x ) I ( y i ≠ c j ) \frac{1}{k} \sum_{x_i \in N_k(x)} I(y_i \neq c_j) k 1 ∑ x i ∈ N k ( x ) I ( y i = c j ) N k ( x ) N_k(x) N k ( x )

算法 :kd_tree ,ball_tree ,brute(蛮力实现,不算优化,只是把 sklearn 中的参数拿过来),以及其它树结构

下面介绍其中的 kd 树(kd tree 是一个二叉树)方法(kd 树是存储 k 维空间数据的树结构,这里的 k 与 k 近邻法的 k 意义不同)。T = { x 1 , . . . , x N } T = \{x_1,...,x_N\} T = { x 1 , ... , x N } x i x_i x i x i = ( x i ( 1 ) , . . . , x i ( k ) ) T x_i = (x_i^{(1)},...,x_i^{(k)})^T x i = ( x i ( 1 ) , ... , x i ( k ) ) T

function kdtree (list of points pointList, int depth)

{

// Select axis based on depth so that axis cycles through all valid values

var int axis := depth mod k;

// Sort point list and choose median as pivot element

select median by axis from pointList;

// Create node and construct subtree

node.location := median;

node.leftChild := kdtree(points in pointList before median, depth+1);

node.rightChild := kdtree(points in pointList after median, depth+1);

return node;

}

根据第(depth mod k)维查找中位数(中位数所在的点作为节点,第一次就是 root 节点),将数据划分为两个区域,小于中位数的划分在左边,大于中位数的划分在右边

重复 1,depth++

在 kd 树中找出包含目标点 x 的叶结点:从根结点出发,递归地向下访问 kd 树。若目标点 x 当前维的坐标小于切分点的坐标,则移动到左子结点,否则移动到右子结点。直到子结点为叶结点为止。

以此叶结点为“当前最近点”。

递归地向上回退,在每个结点进行以下操作:

当回退到根结点时,搜索结束。最后的“当前最近点”即为 x 的最近邻点。

算法

平均

最差的情况

空间

O ( n ) O(n) O ( n ) O ( n ) O(n) O ( n )

搜索

O ( log n ) O(\log n) O ( log n ) O ( n ) O(n) O ( n )

插入

O ( log n ) O(\log n) O ( log n ) O ( n ) O(n) O ( n )

删除

O ( log n ) O(\log n) O ( log n ) O ( n ) O(n) O ( n )

Distance

sklearn.neighbors.DistanceMetric

Distance computations(scipy.spatial.distance)

24 种距离度量小结

先了解度量空间和赋范空间

实值向量空间的度量:

Euclidean(欧几里得距离也称欧式距离) ∣ ∣ u − v ∣ ∣ 2 {||u-v||}_2 ∣∣ u − v ∣∣ 2 ∑ i ( u i − v i ) 2 \sqrt{\sum_i{(u_i - v_i)^2}} ∑ i ( u i − v i ) 2

SEuclidean(标准化欧几里得距离)

SqEuclidean(平方欧几里得距离)

Mahalanobis(马氏距离) ( u − v ) Σ − 1 ( u − v ) T \sqrt{ (u-v) \Sigma^{-1} (u-v)^T } ( u − v ) Σ − 1 ( u − v ) T

Manhattan/cityblock(城市街区(曼哈顿)距离) ∑ i ∣ u i − v i ∣ \sum_i{|u_i-v_i|} ∑ i ∣ u i − v i ∣

Chebyshev(切比雪夫距离) L ∞ L_\infty L ∞ max i ∣ u i − v i ∣ \max_i{|u_i-v_i|} max i ∣ u i − v i ∣

Minkowski(闵可夫斯基距离) 欧式距离的推广,p=1 时等价于曼哈顿距离,p=2 时等价于欧氏距离,p=∞ 时等价于切比雪夫距离;∑ i ( u i − v i ) p p \sqrt[p]{\sum_i{(u_i - v_i)^p}} p ∑ i ( u i − v i ) p

WMinkowski(加权 Minkowski)

实值向量空间的度量(scipy):

Correlation(皮尔逊相关系数(Pearson Correlation))

Cosine(余弦距离)

JensenShannon(JS 散度也称 JS 距离,是 KL 散度的一种变形)

整数值向量空间的度量:

Hamming(汉明距离)

Canberra(堪培拉距离)

BrayCurtis(布雷柯蒂斯距离)

布尔值向量空间的度量:

Jaccard(Jaccard-Needham 不相似度)

Matching(Hamming 同义词)

Dice(Dice 系数)

Kulsinski(Kulsinski 相异度)

RogersTanimoto(Rogers-Tanimoto 相异度)

RussellRao(Russell-Rao 相异性)

SokalMichener(Sokal-Michener 相异性)

SokalSneath(Sokal-Sneath 相异性)

Yule(scipy 中的 Yule 相异度)

经纬度距离:

Haversine(sklearn 中的半正矢距离)

其它:

[3-1] Cover T,Hart P. Nearest neighbor pattern classification. IEEE Transactions onInformation Theory,1967

[3-2] Hastie T,Tibshirani R,Friedman J. The Elements of Statistical Learning: DataMining,Inference,and Prediction,2001(中译本:统计学习基础——数据挖掘、推理与预测。范明,柴玉梅,昝红英等译。北京:电子工业出版社,2004)

[3-3] Friedman J. Flexible metric nearest neighbor classification. Technical Report,1994

[3-4] Weinberger KQ,Blitzer J,Saul LK. Distance metric learning for large margin nearestneighbor classification. In: Proceedings of the NIPS. 2005

[3-5] Samet H. The Design and Analysis of Spatial Data Structures. Reading,MA: Addison-Wesley,1990

朴素贝叶斯(Naïve Bayes )法是基于贝叶斯定理 与特征条件独立假设 (Naive 天真的)的分类方法。

朴素贝叶斯法是典型的生成学习方法 。生成方法由训练数据学习联合概率分布 P(X,Y),然后求得后验概率分布 P(Y|X)。具体来说,利用训练数据学习 P(X|Y)和 P(Y)的估计,得到联合概率分布:P(X,Y)= P(Y)P(X|Y) ;概率估计方法可以是极大似然估计或贝叶斯估计。

贝叶斯定理(Bayes' theorem) P ( A ∣ B ) = P ( B ∣ A ) P ( A ) P ( B ) P(A|B) = \frac{P(B|A)P(A)}{P(B)} P ( A ∣ B ) = P ( B ) P ( B ∣ A ) P ( A )

特征条件独立假设 条件独立 ( A ⊥ B ∣ C ) ⟺ P ( A ∣ B , C ) = P ( A ∣ C ) ( A ⊥ B ∣ C ) ⟺ P ( A , B ∣ C ) = P ( A ∣ C ) P ( B ∣ C ) (A\perp B|C) \iff P(A|B,C) = P(A|C) \\ (A\perp B|C) \iff P(A,B|C) = P(A|C)P(B|C) ( A ⊥ B ∣ C ) ⟺ P ( A ∣ B , C ) = P ( A ∣ C ) ( A ⊥ B ∣ C ) ⟺ P ( A , B ∣ C ) = P ( A ∣ C ) P ( B ∣ C )

特征条件独立假设就是已知 y 的情况下,x 中每个特征相互独立。

数据集T = { ( x 1 , y 1 ) , . . . , ( x N , y N ) } T = \{(x_1,y_1),...,(x_N,y_N)\} T = {( x 1 , y 1 ) , ... , ( x N , y N )} K K K x i x_i x i x i = ( x i ( 1 ) , . . . , x i ( n ) ) T x_i = (x_i^{(1)},...,x_i^{(n)})^T x i = ( x i ( 1 ) , ... , x i ( n ) ) T

模型 :P ( Y = c k ∣ X = x ) = P ( X = x ∣ Y = c k ) P ( Y = c k ) P ( X = x ) ⏟ 贝叶斯定理 ∝ P ( Y = c k ) ∏ j P ( X ( j ) = x ( j ) ∣ Y = c k ) ⏟ 特征条件独立假设 \underbrace{P(Y=c_k|X=x) = \frac{P(X=x|Y=c_k)P(Y=c_k)}{P(X=x)}}_{\text{贝叶斯定理}} \varpropto P(Y=c_k) \underbrace{\prod_j{P(X^{(j)}=x^{(j)}|Y=c_k)}}_{\text{特征条件独立假设}} 贝叶斯定理 P ( Y = c k ∣ X = x ) = P ( X = x ) P ( X = x ∣ Y = c k ) P ( Y = c k ) ∝ P ( Y = c k ) 特征条件独立假设 j ∏ P ( X ( j ) = x ( j ) ∣ Y = c k )

其中P ( X = x ) = ∑ k P ( X = x ∣ Y = c k ) P ( Y = c k ) = ∑ k P ( Y = c k ) ∏ j P ( X ( j ) = x ( j ) ∣ Y = c k ) P(X=x) = \sum_k{P(X=x|Y=c_k)P(Y=c_k)} = \sum_k{P(Y=c_k) \prod_j{P(X^{(j)}=x^{(j)}|Y=c_k)}} P ( X = x ) = k ∑ P ( X = x ∣ Y = c k ) P ( Y = c k ) = k ∑ P ( Y = c k ) j ∏ P ( X ( j ) = x ( j ) ∣ Y = c k ) c k c_k c k P ( Y = c k ∣ X = x ) ∝ P ( X = x ∣ Y = c k ) P ( Y = c k ) P(Y=c_k|X=x) \varpropto {P(X=x|Y=c_k)P(Y=c_k)} P ( Y = c k ∣ X = x ) ∝ P ( X = x ∣ Y = c k ) P ( Y = c k )

策略 :y = arg max c k P ( Y = c k ∣ X = x ) = arg max c k P ( Y = c k ) ∏ j P ( X ( j ) = x ( j ) ∣ Y = c k ) y = \argmax_{c_k} P(Y=c_k|X=x)= \argmax_{c_k}P(Y=c_k)\prod_j{P(X^{(j)}=x^{(j)}|Y=c_k)} y = c k arg max P ( Y = c k ∣ X = x ) = c k arg max P ( Y = c k ) j ∏ P ( X ( j ) = x ( j ) ∣ Y = c k ) arg min y ∑ k = 1 K P ( y ≠ c k ∣ X = x ) = arg min y ( 1 − P ( y = c k ∣ X = x ) ) = arg max y P ( y = c k ∣ X = x ) \argmin_{y}\sum_{k=1}^K P(y \neq c_k|X=x) \\= \argmin_{y}(1- P(y = c_k|X=x)) \\= \argmax_y P(y = c_k|X=x) y arg min k = 1 ∑ K P ( y = c k ∣ X = x ) = y arg min ( 1 − P ( y = c k ∣ X = x )) = y arg max P ( y = c k ∣ X = x )

算法 :参数估计P ( Y = c k ) P(Y=c_k) P ( Y = c k ) ∏ j P ( X ( j ) = x ( j ) ∣ Y = c k ) \prod_j{P(X^{(j)}=x^{(j)}|Y=c_k)} ∏ j P ( X ( j ) = x ( j ) ∣ Y = c k ) 极大似然估计 :

先验P ( Y = c k ) P(Y=c_k) P ( Y = c k ) P ( Y = c k ) = ∑ i = 1 N I ( y i = c k ) N P(Y=c_k) = \frac{\sum_{i=1}^N I(y_i = c_k)}{N} P ( Y = c k ) = N ∑ i = 1 N I ( y i = c k )

第j j j x ( j ) x^{(j)} x ( j ) { a j 1 , . . . , a j S j } \{a_{j1},...,a_{jS_j}\} { a j 1 , ... , a j S j } 注意这里用的都是频率计数,也就是离散特征,如果是连续特征变量,则使用高斯朴素贝叶斯 )P ( X ( j ) = x ( j ) ∣ Y = c k ) P(X^{(j)}=x^{(j)}|Y=c_k) P ( X ( j ) = x ( j ) ∣ Y = c k ) P ( X ( j ) = a j l ∣ Y = c k ) = ∑ i = 1 N I ( x i ( j ) = a j l , y i = c k ) ∑ i = 1 N I ( y i = c k ) P(X^{(j)} = a_{jl}|Y=c_k) = \frac{\sum_{i=1}^N I(x_i^{(j)} =a_{jl} , y_i = c_k)}{\sum_{i=1}^N I(y_i=c_k)} P ( X ( j ) = a j l ∣ Y = c k ) = ∑ i = 1 N I ( y i = c k ) ∑ i = 1 N I ( x i ( j ) = a j l , y i = c k ) j = 1 , 2 , . . . N ; l = 1 , 2... S j ; k = 1 , 2 , . . . K j = 1,2,...N; \quad l=1,2...S_j ;\quad k=1,2,...K j = 1 , 2 , ... N ; l = 1 , 2... S j ; k = 1 , 2 , ... K x i ( j ) x_i^{(j)} x i ( j ) i i i j j j a j l a_{jl} a j l j j j l l l

贝叶斯估计 (smoothed version of maximum likelihood):P ( X ( j ) = x ( j ) ∣ Y = c k ) P(X^{(j)}=x^{(j)}|Y=c_k) P ( X ( j ) = x ( j ) ∣ Y = c k ) j j j x ( j ) = a j S j + 1 x^{(j)} = a_{jS_j+1} x ( j ) = a j S j + 1

注意:朴素贝叶斯法与贝叶斯估计(Bayesian estimation)是不同的概念。

先验P ( Y = c k ) P(Y=c_k) P ( Y = c k ) P ( Y = c k ) = ∑ i = 1 N I ( y i = c k ) + λ N + K λ P(Y=c_k) = \frac{\sum_{i=1}^N I(y_i = c_k) + \lambda}{N + K\lambda} P ( Y = c k ) = N + K λ ∑ i = 1 N I ( y i = c k ) + λ

条件概率(likelihood)的贝叶斯估计是:P ( X ( j ) = a j l ∣ Y = c k ) = ∑ i = 1 N I ( x i ( j ) = a j l , y i = c k ) + λ ∑ i = 1 N I ( y i = c k ) + S j λ P(X^{(j)} = a_{jl}|Y=c_k) = \frac{\sum_{i=1}^N I(x_i^{(j)} = a_{jl} , y_i = c_k) + \lambda}{\sum_{i=1}^N I(y_i=c_k) + S_j\lambda} P ( X ( j ) = a j l ∣ Y = c k ) = ∑ i = 1 N I ( y i = c k ) + S j λ ∑ i = 1 N I ( x i ( j ) = a j l , y i = c k ) + λ

其中λ ≥ 0 \lambda \geq 0 λ ≥ 0 λ = 0 \lambda = 0 λ = 0 λ = 1 \lambda = 1 λ = 1 Laplacian smoothing );当λ < 1 \lambda < 1 λ < 1

高斯朴素贝叶斯:条件概率(likelihood)P ( X ( j ) = x ( j ) ∣ Y = c k ) = 1 2 π σ j , k 2 e x p ( − ( x ( j ) − μ j , k ) 2 2 σ j , k 2 ) P(X^{(j)} = x^{(j)}|Y=c_k) = \frac{1}{\sqrt{2\pi\sigma_{j,k}^2}} exp\bigg(-\frac{(x^{(j)}-\mu_{j,k})^2}{2\sigma_{j,k}^2}\bigg) P ( X ( j ) = x ( j ) ∣ Y = c k ) = 2 π σ j , k 2 1 e x p ( − 2 σ j , k 2 ( x ( j ) − μ j , k ) 2 ) μ j , k \mu_{j,k} μ j , k c k c_k c k x ( j ) x^{(j)} x ( j ) σ j , k 2 \sigma_{j,k}^2 σ j , k 2 c k c_k c k x ( j ) x^{(j)} x ( j ) P ( Y = c k ) P(Y=c_k) P ( Y = c k ) P ( Y = c k ) = ∑ i = 1 N I ( y i = c k ) + λ N + K λ P(Y=c_k) = \frac{\sum_{i=1}^N I(y_i = c_k) + \lambda}{N + K\lambda} P ( Y = c k ) = N + K λ ∑ i = 1 N I ( y i = c k ) + λ

参数估计(Parameter Estimation ) 有点估计(point estimation )和区间估计(interval estimation )两种

点估计法:

极大似然估计(Maximum likelihood estimation, MLE ) 频率学派 观点,它的基本思想是:待估计参数θ \theta θ L ( θ ∣ x ) = f ( x ∣ θ ) = P ( X ∣ θ ) θ ^ M L E = arg max θ L ( θ ∣ x ) L(\theta|x) = f(x|\theta) = P(X|\theta) \\ \hat{\theta}_{MLE} = \argmax_{\theta} L(\theta|x) L ( θ ∣ x ) = f ( x ∣ θ ) = P ( X ∣ θ ) θ ^ M L E = θ arg max L ( θ ∣ x ) P ( X ∣ θ ) P(X|\theta) P ( X ∣ θ ) θ \theta θ c k c_k c k ℓ ( θ ∣ x ) = log L ( θ ∣ x ) \ell(\theta|x) = \log L(\theta|x) ℓ ( θ ∣ x ) = log L ( θ ∣ x )

最大后验估计(maximum a posteriori estimation, MAP ) f ( θ ∣ x ) = f ( x ∣ θ ) g ( θ ) ∫ ϑ f ( x ∣ ϑ ) g ( ϑ ) d ϑ f(\theta|x) = \frac{f(x|\theta)g(\theta)}{\int_\vartheta f(x|\vartheta)g(\vartheta)d\vartheta} f ( θ ∣ x ) = ∫ ϑ f ( x ∣ ϑ ) g ( ϑ ) d ϑ f ( x ∣ θ ) g ( θ ) g g g θ \theta θ θ ^ M A P = arg max θ f ( θ ∣ x ) = arg max θ f ( x ∣ θ ) g ( θ ) ∫ ϑ f ( x ∣ ϑ ) g ( ϑ ) d ϑ = arg max θ f ( x ∣ θ ) g ( θ ) \hat{\theta}_{MAP} = \argmax_{\theta} f(\theta|x) \\= \argmax_{\theta} \frac{f(x|\theta)g(\theta)}{\int_\vartheta f(x|\vartheta)g(\vartheta)d\vartheta} \\= \argmax_{\theta}f(x|\theta)g(\theta) θ ^ M A P = θ arg max f ( θ ∣ x ) = θ arg max ∫ ϑ f ( x ∣ ϑ ) g ( ϑ ) d ϑ f ( x ∣ θ ) g ( θ ) = θ arg max f ( x ∣ θ ) g ( θ ) θ \theta θ θ ^ M A P = arg max θ log f ( x ∣ θ ) g ( θ ) = arg max θ ( log f ( x ∣ θ ) + log g ( θ ) ) \hat{\theta}_{MAP} = \argmax_{\theta}\log{f(x|\theta)g(\theta)} = \argmax_{\theta} (\log{f(x|\theta)} + \log{g(\theta)}) θ ^ M A P = θ arg max log f ( x ∣ θ ) g ( θ ) = θ arg max ( log f ( x ∣ θ ) + log g ( θ ) ) log g ( θ ) \log{g(\theta)} log g ( θ ) 正则化项 ,那么带有正则化项的最大似然学习就可以被解释为 MAP(如:Ridge 回归和 Lasso 回归 )。

最大后验估计就是考虑后验分布极大化而求解参数 的极大似然估计;MAP = 最大似然估计 + 最大似然估计的正则化。

贝叶斯估计(Bayes estimation ) 贝叶斯学派 观点,它的基本思想是:待估计参数 θ \theta θ θ \theta θ 贝叶斯估计需要要计算整个后验概率的概率分布(而 MAP 值需要求解后验分布极大化时的参数θ \theta θ 。

贝叶斯估计和 MAP 挺像的,都是以最大化后验概率为目的。区别在于:

MLE 和 MAP 都是只返回了的预估值

MAP 在计算后验概率的时候,把分母 p(X)给忽略了,在进行贝叶斯估计的时候则不能忽略

贝叶斯估计要计算整个后验概率的概率分布

共轭先验(Conjugate prior ) :如果先验分布 prior 和后验分布 posterior 属于同一分布簇,则 prior 称为 likehood 的共轭先验

最小二乘估计(Least squares estimation, LSE )

矩估计(Method of moments estimators)

区间估计法: confidence intervals (一种频率论方法 )和 可信区间 credible intervals (一种贝叶斯方法 ),此外还有预测区间(Prediction interval )等

采样法: 贝叶斯估计,近似推断Markov chain Monte Carlo, MCMC

[4-1] Mitchell TM. Chapter 1: Generative and discriminative classifiers: Naïve Bayes andlogistic regression. In: Machine Learning. Draft,2005.

[4-2] Hastie T,Tibshirani R,Friedman J. The Elements of Statistical Learning. DataMining,Inference,and Prediction. Springer-Verlag,2001(中译本:统计学习基础——数据挖掘、推理与预测。范明,柴玉梅,昝红英等译。北京:电子工业出版社,2004)

[4-3] Bishop C. Pattern Recognition and Machine Learning ,Springer,2006

判别模型

决策树(decision tree )是一种基本的分类与回归方法,具有良好的可解释性(可视化),通常包括 3 个步骤:特征选择、决策树的生成和决策树的修剪特征选择 :feature_importances_特征重要性,属性越重要,特征空间划分的面积越大)

也就是计算每个特征的(信息增益,基尼指数)来选择特征(作为根节点)进行特征空间划分,注意:划分后再次计算每个特征的(信息增益,基尼指数),除非该特征所在的空间就只有一类了(也就是该特征不可分了,那么就直接生成叶子节点);

特征选择的准则:

决策树的生成 :Decision tree learning 以及Tree algorithms ):

ID3 (Iterative Dichotomiser 3)C4.5 (successor of ID3)CART (Classification And Regression Tree)

决策树的修剪 Decision tree pruning

统计学习方法三要素:

模型 :

策略 :

算法 :

Overview of Decision Trees

Decision Tree

Decision Trees

Entropy, Relative Entropy, Cross Entropy

在信息论中,熵用来衡量一个随机事件的不确定性 。也叫香农熵 Shannon's(人名) entropy。H ( X ) = E p ( x ) [ I ( X ) ] = E p ( x ) [ − log p ( x ) ] = − ∑ i = 1 n p ( x i ) log p ( x i ) = − ∫ X p ( x ) log p ( x ) d x H(X) = E_{p(x)}[I(X)] = E_{p(x)}[-\log {p(x)}] \\= -\sum_{i=1}^n {p(x_i)} \log {p(x_i)} \\= -\int_{X} {p(x)} \log {p(x)} dx H ( X ) = E p ( x ) [ I ( X )] = E p ( x ) [ − log p ( x ) ] = − i = 1 ∑ n p ( x i ) log p ( x i ) = − ∫ X p ( x ) log p ( x ) d x I ( X ) = − log p ( x ) I(X) = -\log {p(x)} I ( X ) = − log p ( x ) 自信息 (Self Information ),是一个随机事件所包含的信息量。一个随机事件发生的概率越高,其自信息越低。如果一个事件必然发生,其自信息为 0。

熵越高,则随机变量的信息越多(不确定性越大,系统越复杂);熵越低,则随机变量的信息越少。

求最大熵:假设概率分布

X

1

2

...

n

p(x)

p₁

p₂

...

pⁿ

max H ( p ) = max − ∑ i = 1 n p i log p i s . t . ∑ i = 1 n p i = 1 \max H(p) = \max -\sum_{i=1}^n p_i \log p_i \\ s.t. \sum_{i=1}^n p_i = 1 max H ( p ) = max − i = 1 ∑ n p i log p i s . t . i = 1 ∑ n p i = 1

由拉格朗日乘数法(Lagrange Multiplier),最大变最小时去掉负号L ( p , λ ) = ∑ i = 1 n p i log p i + λ ( 1 − ∑ i = 1 n p i ) 偏导: ∂ L ∂ p i = log p i + p i . 1 p i − λ 令偏导为 0 得: p i ∗ = e x p ( λ − 1 ) \mathcal L(p,\lambda) = \sum_{i=1}^n p_i \log p_i + \lambda(1-\sum_{i=1}^n p_i) \\偏导:\frac{\partial\mathcal L}{\partial p_i} = \log p_i + p_i.\frac{1}{p_i} - \lambda \\ 令偏导为0得:p_i^*=exp(\lambda-1) L ( p , λ ) = i = 1 ∑ n p i log p i + λ ( 1 − i = 1 ∑ n p i ) 偏导: ∂ p i ∂ L = log p i + p i . p i 1 − λ 令偏导为 0 得: p i ∗ = e x p ( λ − 1 )

因为λ \lambda λ p i ∗ p_i^* p i ∗ p 1 ∗ = p 2 ∗ = . . . = p n ∗ = 1 n p_1^*=p_2^*=...=p_n^*=\frac{1}{n} p 1 ∗ = p 2 ∗ = ... = p n ∗ = n 1

所以概率分布为一个均匀分布,则熵最大 ,由此性质我们来证明熵的取值范围:设 p 是一个均匀分布p = 1 n p = \frac{1}{n} p = n 1 H ( p ) = − ∑ i = 1 n 1 n log 1 n = − ∑ i = 1 n 1 n log n − 1 = ∑ i = 1 n 1 n log n = log n H(p) = -\sum_{i=1}^n \frac{1}{n} \log \frac{1}{n} \\= -\sum_{i=1}^n \frac{1}{n} \log n^{-1} \\= \sum_{i=1}^n \frac{1}{n} \log n \\= \log n H ( p ) = − i = 1 ∑ n n 1 log n 1 = − i = 1 ∑ n n 1 log n − 1 = i = 1 ∑ n n 1 log n = log n 0 ≤ H ( p ) ≤ log n 0 \leq H(p) \leq \log n 0 ≤ H ( p ) ≤ log n

已知连续随机变量的均值为μ \mu μ σ 2 \sigma^2 σ 2 arg max p ( x ) − ∫ p ( x ) log p ( x ) d x s . t . ∫ p ( x ) d x = 1 ∫ x p ( x ) d x = μ ∫ ( x − μ ) 2 p ( x ) d x = σ 2 \argmax_{p(x)} -\int p(x)\log p(x)dx \\ s.t. \int p(x)dx =1 \\ \int xp(x)dx = \mu \\ \int (x-\mu)^2p(x)dx=\sigma^2 p ( x ) arg max − ∫ p ( x ) log p ( x ) d x s . t . ∫ p ( x ) d x = 1 ∫ x p ( x ) d x = μ ∫ ( x − μ ) 2 p ( x ) d x = σ 2 L ( p ( x ) , λ 1 , λ 2 , λ 3 ) = − ∫ p ( x ) log p ( x ) d x + λ 1 ( ∫ p ( x ) d x − 1 ) + λ 2 ( ∫ x p ( x ) d x − μ ) + λ 3 ( ∫ ( x − μ ) 2 p ( x ) d x − σ 2 ) L(p(x),\lambda_1,\lambda_2,\lambda_3) = -\int p(x)\log p(x)dx +\lambda_1(\int p(x)dx - 1)+\lambda_2(\int xp(x)dx - \mu) +\lambda_3(\int (x-\mu)^2p(x)dx - \sigma^2) L ( p ( x ) , λ 1 , λ 2 , λ 3 ) = − ∫ p ( x ) log p ( x ) d x + λ 1 ( ∫ p ( x ) d x − 1 ) + λ 2 ( ∫ x p ( x ) d x − μ ) + λ 3 ( ∫ ( x − μ ) 2 p ( x ) d x − σ 2 ) F ( p ) = ( − log p ( x ) + λ 1 + λ 2 x + λ 3 ( x − μ ) 2 ) p ( x ) F(p)=(-\log p(x) + \lambda_{1} +\lambda_{2}x+ \lambda_{3}(x-\mu)^{2})p(x) F ( p ) = ( − log p ( x ) + λ 1 + λ 2 x + λ 3 ( x − μ ) 2 ) p ( x ) ∂ L ∂ p ( x ) = − [ log p ( x ) + 1 ] + λ 1 + λ 2 x + λ 3 ( x − μ ) 2 \frac{\partial L}{\partial p(x)} = -[\log p(x)+1]+\lambda_1+\lambda_2x+\lambda_3(x-\mu)^2 ∂ p ( x ) ∂ L = − [ log p ( x ) + 1 ] + λ 1 + λ 2 x + λ 3 ( x − μ ) 2 p ( x ) = exp { λ 1 − 1 + λ 2 x + λ 3 ( x − μ ) 2 } p(x) = \exp\{\lambda_1-1+\lambda_2x+\lambda_3(x-\mu)^2\} p ( x ) = exp { λ 1 − 1 + λ 2 x + λ 3 ( x − μ ) 2 } p ( x ) = exp { λ 1 − 1 + λ 2 x + λ 3 ( x − μ ) 2 } = e − 1 + λ 1 ⋅ e λ 2 x + λ 3 ( x − μ ) 2 = C e λ 2 x + λ 3 ( x − μ ) 2 = C e λ 3 ( x 2 − 2 ( μ − λ 2 2 λ 3 ) x + u 2 ) = C e λ 3 ( x − μ + λ 2 2 λ 3 ) 2 = C . exp { λ 3 ( x − μ + λ 2 2 λ 3 ) 2 } p(x) = \exp\{\lambda_1-1+\lambda_2x+\lambda_3(x-\mu)^2\}\\ =e^{-1+\lambda_{1}}\cdot e^{\lambda_{2}x+ \lambda_{3}(x-\mu)^{2}}=C e^{\lambda_{2}x+ \lambda_{3}(x-\mu)^{2}} \\ = Ce^{\lambda_{3}(x^{2} -2(\mu-\frac{\lambda_{2}}{2\lambda_{3}})x+ u^{2})} = C e^{\lambda_{3}(x -\mu+ \frac{\lambda_{2}}{2\lambda_{3}})^{2}} \\= C.\exp\{\lambda_3(x-\mu+\frac{\lambda_2}{2\lambda_3})^2\} p ( x ) = exp { λ 1 − 1 + λ 2 x + λ 3 ( x − μ ) 2 } = e − 1 + λ 1 ⋅ e λ 2 x + λ 3 ( x − μ ) 2 = C e λ 2 x + λ 3 ( x − μ ) 2 = C e λ 3 ( x 2 − 2 ( μ − 2 λ 3 λ 2 ) x + u 2 ) = C e λ 3 ( x − μ + 2 λ 3 λ 2 ) 2 = C . exp { λ 3 ( x − μ + 2 λ 3 λ 2 ) 2 }

根据( x − μ + λ 2 2 λ 3 ) 2 (x-\mu+\frac{\lambda_2}{2\lambda_3})^2 ( x − μ + 2 λ 3 λ 2 ) 2 p ( x ) p(x) p ( x ) μ − λ 2 2 λ 3 \mu - \frac{\lambda_{2}}{2\lambda_{3}} μ − 2 λ 3 λ 2 p ( x ) = p ( − x ) p(x) = p(-x) p ( x ) = p ( − x ) E [ p ( x ) ] = μ − λ 2 2 λ 3 = μ E[p(x)] = \mu - \frac{\lambda_{2}}{2\lambda_{3}} = \mu E [ p ( x )] = μ − 2 λ 3 λ 2 = μ λ 2 = 0 \lambda_{2} = 0 λ 2 = 0

那么p ( x ) = C e λ 3 ( x − μ ) 2 p(x)= C e^{\lambda_{3}(x -\mu)^{2}} p ( x ) = C e λ 3 ( x − μ ) 2 p ( x ) > 0 p(x)>0 p ( x ) > 0 C > 0 , λ 3 < 0 C>0,\lambda_{3}<0 C > 0 , λ 3 < 0 λ = − λ 3 \lambda = -\lambda_3 λ = − λ 3 ∫ e − x 2 2 d x = 2 π \int e^{-\frac{x^2}{2}}dx = \sqrt{2\pi} ∫ e − 2 x 2 d x = 2 π ∫ p ( x ) d x = 1 = C ∫ e − λ ( x − μ ) 2 d x = C π λ \int p(x)dx = 1 = C\int e^{-\lambda(x -\mu)^{2}} dx = C\sqrt{\frac{\pi}{\lambda}} ∫ p ( x ) d x = 1 = C ∫ e − λ ( x − μ ) 2 d x = C λ π C = λ π C = \sqrt{\frac{\lambda}{\pi}} C = π λ ∫ ( x − μ ) 2 p ( x ) d x = σ 2 = ∫ ( x − μ ) 2 e − λ ( x − μ ) 2 d x = C π λ . 1 2 λ = 1 2 λ \int (x-\mu)^2p(x)dx=\sigma^2 = \int (x-\mu)^2e^{-\lambda(x -\mu)^{2}}dx = C\sqrt{\frac{\pi}{\lambda}}.\frac{1}{2\lambda} = \frac{1}{2\lambda} ∫ ( x − μ ) 2 p ( x ) d x = σ 2 = ∫ ( x − μ ) 2 e − λ ( x − μ ) 2 d x = C λ π . 2 λ 1 = 2 λ 1 λ 3 = − 1 2 σ 2 \lambda_3 = -\frac{1}{2\sigma^2} λ 3 = − 2 σ 2 1 C = λ π = 1 2 π σ 2 C = \sqrt{\frac{\lambda}{\pi}} = \sqrt{\frac{1}{2\pi\sigma^2}} C = π λ = 2 π σ 2 1 p ( x ) = 1 2 π σ 2 e − ( x − μ ) 2 2 σ 2 p(x) = \sqrt{\frac{1}{2\pi\sigma^2}} e^{-\frac{(x-\mu)^2}{2\sigma^2}} p ( x ) = 2 π σ 2 1 e − 2 σ 2 ( x − μ ) 2

X X X Y Y Y 联合熵 (Joint Entropy )为:H ( X , Y ) = − ∑ x ∈ X ∑ y ∈ Y P ( x , y ) log 2 [ P ( x , y ) ] = E X , Y [ − log p ( x , y ) ] = − ∑ x , y p ( x , y ) log p ( x , y ) {\displaystyle \mathrm {H} (X,Y)=-\sum _{x\in {\mathcal {X}}}\sum _{y\in {\mathcal {Y}}}P(x,y)\log _{2}[P(x,y)]} \\=\mathbb {E} _{X,Y}[-\log p(x,y)]=-\sum _{x,y}p(x,y)\log p(x ,y)\, H ( X , Y ) = − x ∈ X ∑ y ∈ Y ∑ P ( x , y ) log 2 [ P ( x , y )] = E X , Y [ − log p ( x , y )] = − x , y ∑ p ( x , y ) log p ( x , y )

积分形式(连续):h ( X , Y ) = − ∫ X , Y f ( x , y ) log f ( x , y ) d x d y {\displaystyle h(X,Y)=-\int _{{\mathcal {X}},{\mathcal {Y}}}f(x,y)\log f(x,y)\,dxdy} h ( X , Y ) = − ∫ X , Y f ( x , y ) log f ( x , y ) d x d y

多个随机变量:H ( X 1 , . . . , X n ) = − ∑ x 1 ∈ X 1 . . . ∑ x n ∈ X n P ( x 1 , . . . , x n ) log 2 [ P ( x 1 , . . . , x n ) ] {\displaystyle \mathrm {H} (X_{1},...,X_{n})=-\sum _{x_{1}\in {\mathcal {X}}_{1}}...\sum _{x_{n}\in {\mathcal {X}}_{n}}P(x_{1},...,x_{n})\log _{2}[P(x_{1},...,x_{n})]} H ( X 1 , ... , X n ) = − x 1 ∈ X 1 ∑ ... x n ∈ X n ∑ P ( x 1 , ... , x n ) log 2 [ P ( x 1 , ... , x n )] h ( X 1 , … , X n ) = − ∫ f ( x 1 , … , x n ) log f ( x 1 , … , x n ) d x 1 … d x n {\displaystyle h(X_{1},\ldots ,X_{n})=-\int f(x_{1},\ldots ,x_{n})\log f(x_{1},\ldots ,x_{n})\,dx_{1}\ldots dx_{n}} h ( X 1 , … , X n ) = − ∫ f ( x 1 , … , x n ) log f ( x 1 , … , x n ) d x 1 … d x n

X X X Y Y Y 条件熵 (Conditional Entropy )为:

H ( Y ∣ X ) = − ∑ x ∈ X , y ∈ Y p ( x , y ) log p ( x , y ) p ( x ) {\displaystyle \mathrm {H} (Y|X)\ =-\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}p(x,y)\log {\frac {p(x,y)}{p(x)}}} H ( Y ∣ X ) = − x ∈ X , y ∈ Y ∑ p ( x , y ) log p ( x ) p ( x , y )

证明:H ( Y ∣ X ) ≡ ∑ x ∈ X p ( x ) H ( Y ∣ X = x ) = − ∑ x ∈ X p ( x ) ∑ y ∈ Y p ( y ∣ x ) log p ( y ∣ x ) = − ∑ x ∈ X ∑ y ∈ Y p ( x , y ) log p ( y ∣ x ) = − ∑ x ∈ X , y ∈ Y p ( x , y ) log p ( y ∣ x ) = − ∑ x ∈ X , y ∈ Y p ( x , y ) log p ( x , y ) p ( x ) . = ∑ x ∈ X , y ∈ Y p ( x , y ) log p ( x ) p ( x , y ) . {\displaystyle {\begin{aligned}\mathrm {H} (Y|X)\ &\equiv \sum _{x\in {\mathcal {X}}}\,p(x)\,\mathrm {H} (Y|X=x)\\&=-\sum _{x\in {\mathcal {X}}}p(x)\sum _{y\in {\mathcal {Y}}}\,p(y|x)\,\log \,p(y|x)\\&=-\sum _{x\in {\mathcal {X}}}\sum _{y\in {\mathcal {Y}}}\,p(x,y)\,\log \,p(y|x)\\&=-\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}p(x,y)\log \,p(y|x)\\&=-\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}p(x,y)\log {\frac {p(x,y)}{p(x)}}.\\&=\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}p(x,y)\log {\frac {p(x)}{p(x,y)}}.\\\end{aligned}}} H ( Y ∣ X ) ≡ x ∈ X ∑ p ( x ) H ( Y ∣ X = x ) = − x ∈ X ∑ p ( x ) y ∈ Y ∑ p ( y ∣ x ) log p ( y ∣ x ) = − x ∈ X ∑ y ∈ Y ∑ p ( x , y ) log p ( y ∣ x ) = − x ∈ X , y ∈ Y ∑ p ( x , y ) log p ( y ∣ x ) = − x ∈ X , y ∈ Y ∑ p ( x , y ) log p ( x ) p ( x , y ) . = x ∈ X , y ∈ Y ∑ p ( x , y ) log p ( x , y ) p ( x ) .

积分形式(连续):h ( X ∣ Y ) = − ∫ X , Y f ( x , y ) log f ( x ∣ y ) d x d y {\displaystyle h(X|Y)=-\int _{{\mathcal {X}},{\mathcal {Y}}}f(x,y)\log f(x|y)\,dxdy} h ( X ∣ Y ) = − ∫ X , Y f ( x , y ) log f ( x ∣ y ) d x d y

根据定义写作:H ( Y ∣ X ) = H ( X , Y ) − H ( X ) {\displaystyle \mathrm {H} (Y|X)\,=\,\mathrm {H} (X,Y)-\mathrm {H} (X)} H ( Y ∣ X ) = H ( X , Y ) − H ( X ) H ( X 1 , X 2 , … , X n ) = ∑ i = 1 n H ( X i ∣ X 1 , … , X i − 1 ) {\displaystyle \mathrm {H} (X_{1},X_{2},\ldots ,X_{n})=\sum _{i=1}^{n}\mathrm {H} (X_{i}|X_{1},\ldots ,X_{i-1})} H ( X 1 , X 2 , … , X n ) = i = 1 ∑ n H ( X i ∣ X 1 , … , X i − 1 )

证明:H ( Y ∣ X ) = ∑ x ∈ X , y ∈ Y p ( x , y ) log ( p ( x ) p ( x , y ) ) = ∑ x ∈ X , y ∈ Y p ( x , y ) ( log ( p ( x ) ) − log ( p ( x , y ) ) ) = − ∑ x ∈ X , y ∈ Y p ( x , y ) log ( p ( x , y ) ) + ∑ x ∈ X , y ∈ Y p ( x , y ) log ( p ( x ) ) = H ( X , Y ) + ∑ x ∈ X p ( x ) log ( p ( x ) ) = H ( X , Y ) − H ( X ) . {\displaystyle {\begin{aligned}\mathrm {H} (Y|X)&=\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}p(x,y)\log \left({\frac {p(x)}{p(x,y)}}\right)\\[4pt]&=\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}p(x,y)(\log(p(x))-\log(p(x,y)))\\[4pt]&=-\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}p(x,y)\log(p(x,y))+\sum _{x\in {\mathcal {X}},y\in {\mathcal {Y}}}{p(x,y)\log(p(x))}\\[4pt]&=\mathrm {H} (X,Y)+\sum _{x\in {\mathcal {X}}}p(x)\log(p(x))\\[4pt]&=\mathrm {H} (X,Y)-\mathrm {H} (X).\end{aligned}}} H ( Y ∣ X ) = x ∈ X , y ∈ Y ∑ p ( x , y ) log ( p ( x , y ) p ( x ) ) = x ∈ X , y ∈ Y ∑ p ( x , y ) ( log ( p ( x )) − log ( p ( x , y ))) = − x ∈ X , y ∈ Y ∑ p ( x , y ) log ( p ( x , y )) + x ∈ X , y ∈ Y ∑ p ( x , y ) log ( p ( x )) = H ( X , Y ) + x ∈ X ∑ p ( x ) log ( p ( x )) = H ( X , Y ) − H ( X ) .

如果变量 𝑋 和 𝑌 互相独立,它们的互信息为零.

I ( X ; Y ) = E X , Y [ S I ( x , y ) ] = ∑ x , y p ( x , y ) log p ( x , y ) p ( x ) p ( y ) I(X;Y)=\mathbb {E} _{X,Y}[SI(x,y)]=\sum _{x,y}p(x,y)\log {\frac {p(x,y)}{p(x)\,p(y)}} I ( X ; Y ) = E X , Y [ S I ( x , y )] = x , y ∑ p ( x , y ) log p ( x ) p ( y ) p ( x , y ) pointwise mutual information

基本性质:I ( X ; Y ) = H ( X ) − H ( X ∣ Y ) = H ( Y ) − H ( Y ∣ X ) . I(X;Y)=H(X)-H(X|Y) =H(Y)- H(Y|X).\, I ( X ; Y ) = H ( X ) − H ( X ∣ Y ) = H ( Y ) − H ( Y ∣ X ) . I ( X ; Y ) = I ( Y ; X ) = H ( X ) + H ( Y ) − H ( X , Y ) . I(X;Y)=I(Y;X)=H(X)+H(Y)-H(X,Y).\, I ( X ; Y ) = I ( Y ; X ) = H ( X ) + H ( Y ) − H ( X , Y ) .

互信息可以表示为给定 Y 值的 X 的后验概率分布 与 X 的先验分布之间的平均 Kullback-Leibler 散度:I ( X ; Y ) = E p ( y ) [ D K L ( p ( X ∣ Y = y ) ∥ p ( X ) ) ] . I(X;Y)=\mathbb {E} _{p(y)}[D_{\mathrm {KL} }(p(X|Y=y)\|p(X))]. I ( X ; Y ) = E p ( y ) [ D KL ( p ( X ∣ Y = y ) ∥ p ( X ))] . I ( X ; Y ) = D K L ( p ( X , Y ) ∥ p ( X ) p ( Y ) ) . I(X;Y)=D_{\mathrm {KL} }(p(X,Y)\|p(X)p(Y)). I ( X ; Y ) = D KL ( p ( X , Y ) ∥ p ( X ) p ( Y )) .

统计学习方法中讲到 信息增益等价互信息(74 页),而维基百科中信息增益是Kullback-Leibler 散度

在给定 分布 𝑝 的情况下,如果 分布 𝑞 和 分布 𝑝 越接近,交叉熵越小;如果 分布 𝑞 和 分布 𝑝 越远,交叉H ( p , q ) = − E p [ log q ] = − ∑ x ∈ X p ( x ) log q ( x ) = H ( p ) + D K L ( p ∥ q ) {\displaystyle H(p,q)=-\operatorname {E} _{p}[\log q]} =-\sum _{x\in {\mathcal {X}}}p(x)\,\log q(x) = H(p)+D_{\mathrm {KL} }(p\|q) H ( p , q ) = − E p [ log q ] = − x ∈ X ∑ p ( x ) log q ( x ) = H ( p ) + D KL ( p ∥ q )

注意与联合熵H ( X , Y ) {H} (X,Y) H ( X , Y ) H ( p , q ) H(p,q) H ( p , q ) H q ( p ) H_q(p) H q ( p ) Difference of notation between cross entropy and joint entropy 以及Relation between cross entropy and joint entropy

KL 散度(Kullback-Leibler Divergence),也叫 KL 距离或相对熵(Relative Entropy),是用概率分布 𝑞 来近似 𝑝 时所造成的信息损失量,KL 散度总是大于等于 0 的。可以衡量两个概率分布之间的距离 .KL 散度只有当 𝑝 = 𝑞 时,KL(𝑝, 𝑞) = 0.如果两个分布越接近,KL 散度越小;如果两个分布越远,KL 散度就越大.但 KL 散度并不是一个真正的度量或距离,一是 KL 散度不满足距离的对称性,二是 KL 散度不满足距离的三角不等式性质.

D K L ( p ( X ) ∥ q ( X ) ) = ∑ x ∈ X − p ( x ) log q ( x ) − ∑ x ∈ X − p ( x ) log p ( x ) = ∑ x ∈ X p ( x ) log p ( x ) q ( x ) = − ∑ x ∈ X p ( x ) log q ( x ) p ( x ) . D_{\mathrm {KL} }(p(X)\|q(X))=\sum _{x\in X}-p(x)\log {q(x)}\,-\,\sum _{x\in X}-p(x)\log {p(x)} \\=\sum _{x\in X}p(x)\log {\frac {p(x)}{q(x)}} = -\sum _{x\in X}p(x)\log {\frac {q(x)}{p(x)}}. D KL ( p ( X ) ∥ q ( X )) = x ∈ X ∑ − p ( x ) log q ( x ) − x ∈ X ∑ − p ( x ) log p ( x ) = x ∈ X ∑ p ( x ) log q ( x ) p ( x ) = − x ∈ X ∑ p ( x ) log p ( x ) q ( x ) . K L ( p , q ) , K L ( p ∣ q ) , K L ( p ∥ q ) , D K L ( p , q ) KL(p,q) , KL(p|q) , KL(p\|q) , D_{KL}(p,q) K L ( p , q ) , K L ( p ∣ q ) , K L ( p ∥ q ) , D K L ( p , q )

应用:如:变分推断

JS 散度(Jensen-Shannon Divergence)是一种对称的衡量两个分布相似度的度量方式,是 KL 散度一种改进.但两种散度都存在一个问题,即如果两个分布 𝑝, 𝑞 没有重叠或者重叠非常少时,KL 散度和 JS 散度都很难衡量两个分布的距离.

D J S ( P ∥ Q ) = 1 2 D K L ( P ∥ M ) + 1 2 D K L ( Q ∥ M ) {{\rm {D}_{JS}}}(P\parallel Q)={\frac {1}{2}}D_{KL}(P\parallel M)+{\frac {1}{2}}D_{KL}(Q\parallel M) D JS ( P ∥ Q ) = 2 1 D K L ( P ∥ M ) + 2 1 D K L ( Q ∥ M ) M = 1 2 ( P + Q ) M={\frac {1}{2}}(P+Q) M = 2 1 ( P + Q ) J S D ( P ∥ Q ) , J S ( P ∥ Q ) , J S ( P , Q ) JSD(P\|Q), JS(P\|Q) ,JS(P,Q) J S D ( P ∥ Q ) , J S ( P ∥ Q ) , J S ( P , Q )

属于一种统计距离(Statistical distance )

统计距离还有Wasserstein 距离 Wasserstein distance ,也用于衡量两个分布之间的距μ , ν , p t h − W a s s e r s t e i n \mu ,\nu,p^{th}-Wasserstein μ , ν , p t h − Wa ssers t e in

W p ( μ , ν ) : = ( inf γ ∈ Γ ( μ , ν ) ∫ M × M d ( x , y ) p d γ ( x , y ) ) 1 / p , {\displaystyle W_{p}(\mu ,\nu ):=\left(\inf _{\gamma \in \Gamma (\mu ,\nu )}\int _{M\times M}d(x,y)^{p}\,\mathrm {d} \gamma (x,y)\right)^{1/p},} W p ( μ , ν ) := ( γ ∈ Γ ( μ , ν ) inf ∫ M × M d ( x , y ) p d γ ( x , y ) ) 1/ p ,

Wasserstein 距离相比 KL 散度和 JS 散度的优势在于:即使两个分布没有重叠或者重叠非常少,Wasserstein 距离仍然能反映两个分布的远近.参见pdf443 页附录

[5-1] Olshen R A, Quinlan J R. Induction of decision trees . Machine Learning,1986,1(1): 81–106

[5-2] Olshen R A, Quinlan J R. C4. 5: Programs for Machine Learning . Morgan Kaufmann,1992

[5-3] Olshen R A, Breiman L,Friedman J,Stone C. Classification and Regression Trees. Wadsworth,1984

[5-4] Ripley B. Pattern Recognition and Neural Networks. Cambridge UniversityPress,1996

[5-5] Liu B. Web Data Mining: Exploring Hyperlinks,Contents and Usage Data. Springer-Verlag,2006

[5-6] Hyafil L,Rivest R L. Constructing Optimal Binary Decision Trees is NP-complete.Information Processing Letters,1976,5(1): 15–17

[5-7] Hastie T,Tibshirani R,Friedman JH. The Elements of Statistical Learning: DataMining,Inference,and Prediction . New York: Springer-Verlag,2001

[5-8] Yamanishi K. A learning criterion for stochastic rules. Machine Learning,1992

[5-9] Li H,Yamanishi K. Text classification using ESC-based stochastic decision lists.Information Processing & Management,2002,38(3): 343–361

逻辑斯谛回归 (logistic regression )(也有称 对数几率回归)是统计学习中的经典分类方法。最大熵是概率模型学习的一个准则,将其推广到分类问题得到最大熵模型 (maximum entropy model )。逻辑斯谛回归模型与最大熵模型都属于对数线性模型 (也有称最大熵分类或对数线性分类,所以这里的模型都是分类模型)。

一个事件的几率(odds)是指该事件发生的概率与该事件不发生的概率的比值。如果事件发生的概率是 p,那么该事件的几率是p 1 − p \frac{p}{1-p} 1 − p p 对数几率 (log odds)或 logit 函数是:l o g i t ( p ) = log p 1 − p (6-1) logit(p) = \log\frac{p}{1-p} \label{6-1}\tag{6-1} l o g i t ( p ) = log 1 − p p ( 6-1 )

模型 :P ( Y = 1 ∣ x ) = exp ( w . x ) 1 + exp ( w . x ) = σ ( w . x ) P ( Y = 0 ∣ x ) = 1 1 + exp ( w . x ) = 1 − σ ( w . x ) (6-2) P(Y=1|x) = \frac{\exp{(w.x)}}{1+\exp{(w.x)}} = \sigma{(w.x)} \\ P(Y=0|x) = \frac{1}{1+\exp{(w.x)}} = 1 - \sigma{(w.x)} \label{6-2}\tag{6-2} P ( Y = 1∣ x ) = 1 + exp ( w . x ) exp ( w . x ) = σ ( w . x ) P ( Y = 0∣ x ) = 1 + exp ( w . x ) 1 = 1 − σ ( w . x ) ( 6-2 )

该事件的对数几率:log P ( Y = 1 ∣ x ) 1 − P ( Y = 1 ∣ x ) = w . x \log\frac{P(Y=1|x)}{1-P(Y=1|x)} = w.x log 1 − P ( Y = 1∣ x ) P ( Y = 1∣ x ) = w . x

策略 :T = { ( x 1 , y 1 ) , . . . , ( x N , y N ) } , x i ∈ R n , y i ∈ { 0 , 1 } T=\{(x_1,y_1),...,(x_N,y_N)\} , x_i \in \mathbb{R}^n , y_i \in \{0,1\} T = {( x 1 , y 1 ) , ... , ( x N , y N )} , x i ∈ R n , y i ∈ { 0 , 1 } [ σ ( w . x i ) ] y i [ 1 − σ ( w . x i ) ] 1 − y i [\sigma{(w.x_i)}]^{y_i}[1-\sigma{(w.x_i)}]^{1-y_i} [ σ ( w . x i ) ] y i [ 1 − σ ( w . x i ) ] 1 − y i L ( w ∣ y ; x ) = P ( Y ∣ X ; w ) = ∏ i = 1 N P ( y i ∣ x i ; w ) = ∏ i = 1 N [ σ ( w . x i ) ] y i [ 1 − σ ( w . x i ) ] 1 − y i L(w|y;x) = P(Y|X;w) = \prod_{i=1}^N P(y_i|x_i;w)= \prod_{i=1}^N [\sigma{(w.x_i)}]^{y_i}[1-\sigma{(w.x_i)}]^{1-y_i} L ( w ∣ y ; x ) = P ( Y ∣ X ; w ) = i = 1 ∏ N P ( y i ∣ x i ; w ) = i = 1 ∏ N [ σ ( w . x i ) ] y i [ 1 − σ ( w . x i ) ] 1 − y i

log likelihood(maximized):log L ( w ∣ y ; x ) = ∑ i = 1 N [ y i log σ ( w . x i ) + ( 1 − y i ) log ( 1 − σ ( w . x i ) ) ] \log {L(w|y;x)} = \sum_{i=1}^N[y_i\log\sigma{(w.x_i)} + (1-y_i)\log(1-\sigma{(w.x_i)})] log L ( w ∣ y ; x ) = i = 1 ∑ N [ y i log σ ( w . x i ) + ( 1 − y i ) log ( 1 − σ ( w . x i ) )]

negative log likelihood(minimize):− log L ( w ∣ y ; x ) -\log {L(w|y;x)} − log L ( w ∣ y ; x )

算法 :

极大似然估计 MLE(Maximum Likelihood Estimation)w ∗ = arg min w − log L ( w ∣ y ; x ) w^* = \argmin_w -\log {L(w|y;x)} w ∗ = w arg min − log L ( w ∣ y ; x )

然后使用随机梯度下降法(Stochastic Gradient Descent)求最优值处的参数

sklearn 中代价函数 y ∈ { − 1 , + 1 } y \in \{-1,+1\} y ∈ { − 1 , + 1 } P ( Y = + 1 ∣ x ) = exp ( w . x ) 1 + exp ( w . x ) = σ ( w . x ) P ( Y = − 1 ∣ x ) = 1 1 + exp ( w . x ) = 1 − σ ( w . x ) = σ ( − w . x ) P(Y=+1|x) = \frac{\exp{(w.x)}}{1+\exp{(w.x)}} = \sigma{(w.x)} \\ P(Y=-1|x) = \frac{1}{1+\exp{(w.x)}} = 1 - \sigma{(w.x)} = \sigma{(-w.x)} P ( Y = + 1∣ x ) = 1 + exp ( w . x ) exp ( w . x ) = σ ( w . x ) P ( Y = − 1∣ x ) = 1 + exp ( w . x ) 1 = 1 − σ ( w . x ) = σ ( − w . x ) σ ( y i . w . x i ) \sigma{(y_i.w.x_i)} σ ( y i . w . x i )

− log ∏ i = 1 N σ ( y i . w . x i ) = ∑ i = 1 N − log σ ( y i . w . x i ) = ∑ i = 1 N log 1 σ ( y i . w . x i ) = ∑ i = 1 N log 1 exp ( y i . w . x i ) 1 + exp ( y i . w . x i ) = ∑ i = 1 N log ( 1 + 1 exp ( y i . w . x i ) ) = ∑ i = 1 N log ( 1 + exp ( − y i . w . x i ) ) -\log\prod_{i=1}^N \sigma{(y_i.w.x_i)} = \sum_{i=1}^N-\log\sigma{(y_i.w.x_i)}= \sum_{i=1}^N \log\frac{1}{\sigma{(y_i.w.x_i)}} \\=

\sum_{i=1}^N \log\frac{1}{\frac{\exp{(y_i.w.x_i)}}{1+\exp{(y_i.w.x_i)}}}\\= \sum_{i=1}^N \log(1+\frac{1}{\exp{(y_i.w.x_i)}})\\= \sum_{i=1}^N \log(1+\exp{(-y_i.w.x_i)}) − log i = 1 ∏ N σ ( y i . w . x i ) = i = 1 ∑ N − log σ ( y i . w . x i ) = i = 1 ∑ N log σ ( y i . w . x i ) 1 = i = 1 ∑ N log 1 + e x p ( y i . w . x i ) e x p ( y i . w . x i ) 1 = i = 1 ∑ N log ( 1 + exp ( y i . w . x i ) 1 ) = i = 1 ∑ N log ( 1 + exp ( − y i . w . x i ) )

当然 sklearn 中加入的正则项。

Softmax 回归是 Logistic 回归的多分类情况。

逻辑斯蒂回归模型的思想跟线性回归模型思想不一样,线性回归模型思想是最小化真实值与模型预测值的误差,而逻辑斯蒂回归模型思想就比较狠了,预测值预测对了损失函数就是 0,错了损失就是无穷大,我个人的理解(一般采用的是-log(h(x)) 这是一个凸函数,刚好满足要求)

熵的概念在统计学习与机器学习中真是很重要,最大熵模型(maximum entropy model )是概率模型学习中一个准则,其思想为:在学习概率模型时,所有可能的模型中熵最大的模型是最好的模型;若概率模型需要满足一些约束,则最大熵原理(Principle of maximum entropy)就是在满足已知约束的条件集合中选择熵最大模型。

均值和方差也被称为一阶矩和二阶矩(二至四阶中心矩被定义为方差(variance)、偏度(skewness)和峰度(kurtosis))证明 )证明 过)

模型 :h ( X ) = − ∫ p ( x ) log p ( x ) d x h(X) = - \int p(x)\log p(x) dx h ( X ) = − ∫ p ( x ) log p ( x ) d x

策略 :Maximize p h ( p ) = − ∫ S p ( x ) log p ( x ) d x Subject to ∫ S p ( x ) d x = 1 p ( x ) ≥ 0 ∫ S p ( x ) f i ( x ) d x = α i , i = 1 , 2 , 3 , … , n \begin{array}{ll}

&\underset{p}{\text{Maximize}} & \displaystyle h(p) = - \int_S p(x)\log p(x) dx \\

&\text{Subject to} &\displaystyle \int_S p(x) dx = 1 \\[2pt]

&~ & p(x) \ge 0 \\[2pt]

&~ & \displaystyle \int_S p(x) f_i(x) dx = \alpha_i, ~i=1,2,3,\dots,n

\end{array} p Maximize Subject to h ( p ) = − ∫ S p ( x ) log p ( x ) d x ∫ S p ( x ) d x = 1 p ( x ) ≥ 0 ∫ S p ( x ) f i ( x ) d x = α i , i = 1 , 2 , 3 , … , n 矩约束 (均值和方差也被称为一阶矩和二阶矩),在模型中有时会假设随机变量的矩为常数),并且能够使得熵最大。将上述优化问题写成标准形式:Minimize p ∫ S p ( x ) log p ( x ) d x Subject to − p ( x ) ≤ 0 ∫ S p ( x ) d x = 1 ∫ S p ( x ) f i ( x ) d x = α i , i = 1 , 2 , 3 , … , n \begin{array}{ll}

&\underset{p}{\text{Minimize}} & \displaystyle \int_S p(x)\log p(x) dx \\

&\text{Subject to} &-p(x) \le 0 \\[2pt]

&~ &\displaystyle \int_S p(x) dx = 1 \\

&~ & \displaystyle \int_S p(x) f_i(x) dx = \alpha_i, ~i=1,2,3,\dots,n

\end{array} p Minimize Subject to ∫ S p ( x ) log p ( x ) d x − p ( x ) ≤ 0 ∫ S p ( x ) d x = 1 ∫ S p ( x ) f i ( x ) d x = α i , i = 1 , 2 , 3 , … , n

算法 :L ( p , λ ) = ∫ S p log p d x − μ − 1 p + μ 0 ( ∫ S p d x − 1 ) + ∑ j = 1 n λ j ( ∫ S p f j d x − α j ) L(p,\boldsymbol{\lambda}) = \int_S p\log p ~dx - \mu_{-1}p + \mu_0 \left(\int_S p ~dx - 1\right) + \sum_{j=1}^n \lambda_j \left(\int_S pf_j~dx - \alpha_j\right) L ( p , λ ) = ∫ S p log p d x − μ − 1 p + μ 0 ( ∫ S p d x − 1 ) + j = 1 ∑ n λ j ( ∫ S p f j d x − α j ) ∂ L ∂ p = ln p + 1 − μ − 1 + μ 0 + ∑ j = 1 n λ j f j : = 0 ⟹ p = exp ( − 1 + μ − 1 − μ 0 − ∑ j = 1 n λ j f j ) = c ∗ e − ∑ j = 1 n λ j ∗ f j ( x ) : = p ∗ \begin{gathered}

\frac{\partial L}{\partial p} = \ln p + 1 - \mu_{-1} + \mu_0 + \sum_{j=1}^n \lambda_jf_j := 0 \\

\implies p = \exp\left(-1 + \mu_{-1} - \mu_0 - \sum_{j=1}^n \lambda_j f_j \right) =\displaystyle c^* e^{-\sum_{j=1}^n\lambda_j^* f_j(x)} := p^*

\end{gathered} ∂ p ∂ L = ln p + 1 − μ − 1 + μ 0 + j = 1 ∑ n λ j f j := 0 ⟹ p = exp ( − 1 + μ − 1 − μ 0 − j = 1 ∑ n λ j f j ) = c ∗ e − ∑ j = 1 n λ j ∗ f j ( x ) := p ∗

逻辑回归(非常详细) 机器学习实现与分析之四(广义线性模型)

逻辑回归——Logistic 的起源 Logistic 回归的起源(上) Logistic 回归的起源(中) Logistic 回归的起源(下)

6.2 Logistic Regression and the Cross Entropy Cost - Logistic regression - y 属于 0 或 1

6.3 Logistic Regression and the Softmax Cost-Logistic regression sklearn 中的代价函数,这里的 y 属于-1 或 1

Generalized Linear Models (GLM)

Generalized Linear Models

Generalized Linear Models Explained with Examples

Generalized Linear Model Theory - 推荐

Generalized Linear Models

在线性回归模型中的假设中,有两点需要提出:

假设因变量服从高斯分布:Y = θ T x + ξ Y={{\theta }^{T}}x+\xi Y = θ T x + ξ ξ ∼ N ( 0 , σ 2 ) \xi \sim N(0,{{\sigma }^{2}}) ξ ∼ N ( 0 , σ 2 ) Y ∼ N ( θ T x , σ 2 ) Y\sim N({{\theta }^{T}}x,{{\sigma }^{2}}) Y ∼ N ( θ T x , σ 2 )

模型预测的输出为E [ Y ] E[Y] E [ Y ] Y = θ T x + ξ Y={{\theta }^{T}}x+\xi Y = θ T x + ξ E [ Y ] = E [ θ T x + ξ ] = θ T x E[Y]=E[{{\theta }^{T}}x+\xi ]={{\theta }^{T}}x E [ Y ] = E [ θ T x + ξ ] = θ T x η = θ T x \eta ={{\theta }^{T}}x η = θ T x η = E [ Y ] \eta =E[Y] η = E [ Y ]

广义线性模型可以认为在以上两点假设做了扩展:

因变量分布不一定是高斯分布,服从一个指数分布族(Exponential family )即可。

模型预测输出仍然可以认为是E [ Y ] E[Y] E [ Y ] E [ T ( Y ) ] E[T(Y)] E [ T ( Y )] T ( Y ) = Y T(Y)=Y T ( Y ) = Y Y Y Y E [ Y ] E[Y] E [ Y ] η = θ T x \eta ={{\theta }^{T}}x η = θ T x η = g ( E [ Y ] ) \eta =g(E[Y]) η = g ( E [ Y ]) η \eta η

由于以上两点的扩展,广义线性模型的应用比基本线性模型广泛许多。对于广义线性这个术语,可以理解为广义体现在因变量的分布形式比较广,只要是一指数分布族即可,而线性则体现在自然参数η = θ T x \eta ={{\theta }^{T}}x η = θ T x θ \theta θ

这一家族中的模型形式基本上都差不多,不同的就是因变量(Y)不同,如果是连续的,就是多重线性回归,如果是伯努利分布,就是 logistic 回归,如果是 poisson 分布,就是 poisson 回归,如果是负二项分布,就是负二项回归,等等。只要注意区分它们的因变量就可以了。logistic 回归的因变量可以是二分类的(二项逻辑回归),也可以是多分类的(多项逻辑回归或者 softmax 回归),但是二分类的更为常用,也更加容易解释。所以实际中最为常用的就是二分类的 logistic 回归。

根据sklearn 中的广义线性回归 Generalized Linear Regression 的第二种方式exponential dispersion model (EDM) :

其实就是要让真实 y 与预测 y 之间的差异越小越好:min w 1 2 n samples ∑ i d ( y i , y ^ i ) + α 2 ∥ w ∥ 2 \min_{w} \frac{1}{2 n_{\text{samples}}} \sum_i d(y_i, \hat{y}_i) + \frac{\alpha}{2} \|w\|_2 w min 2 n samples 1 i ∑ d ( y i , y ^ i ) + 2 α ∥ w ∥ 2

假设 y 分别符合下列分布,求真实 y 与预测 y 之间的差异(Deviance)(log 相减不就是两个概率之间的比吗?不就是对数几率(log odds)吗?对数几率为 0 时不就是概率比为 1 吗?不就是差异最小么!):

Normal(Gaussian) :f ( y ; μ , σ ) = 1 2 π σ 2 exp ( − ( y − μ ) 2 2 σ 2 ) f(y;\mu,\sigma) = \frac{1}{\sqrt{2\pi\sigma^2}}\exp(-\frac{(y-\mu)^2}{2\sigma^2}) f ( y ; μ , σ ) = 2 π σ 2 1 exp ( − 2 σ 2 ( y − μ ) 2 ) log f ( y ; μ , σ ) = − log 2 π σ 2 − y 2 − 2 y μ + μ 2 2 σ 2 = − log 2 π σ 2 − y 2 2 σ 2 − − 2 y μ + μ 2 2 σ 2 \log f(y;\mu,\sigma) = -\log\sqrt{2\pi\sigma^2} - \frac{y^2-2y\mu+\mu^2}{2\sigma^2}= -\log\sqrt{2\pi\sigma^2} - \frac{y^2}{2\sigma^2} - \frac{-2y\mu+\mu^2}{2\sigma^2} log f ( y ; μ , σ ) = − log 2 π σ 2 − 2 σ 2 y 2 − 2 y μ + μ 2 = − log 2 π σ 2 − 2 σ 2 y 2 − 2 σ 2 − 2 y μ + μ 2 y ^ \hat{y} y ^ μ \mu μ log f ( y ; y , σ ) − log f ( y ; y ^ , σ ) = − − 2 y . y + y 2 2 σ 2 − ( − − 2 y . y ^ + y ^ 2 2 σ 2 ) = y 2 − 2 y . y ^ + y ^ 2 2 σ 2 = ( y − y ^ ) 2 2 σ 2 = D ( y , y ^ ) 2 σ 2 \log f(y;y,\sigma) - \log f(y;\hat{y},\sigma) = - \frac{-2y.y+y^2}{2\sigma^2} - (- \frac{-2y.\hat{y}+\hat{y}^2}{2\sigma^2}) \\= \frac{y^2 -2y.\hat{y}+\hat{y}^2}{2\sigma^2} \\= \frac{(y-\hat{y})^2}{2\sigma^2} \\= \frac{D(y,\hat{y})}{2\sigma^2} log f ( y ; y , σ ) − log f ( y ; y ^ , σ ) = − 2 σ 2 − 2 y . y + y 2 − ( − 2 σ 2 − 2 y . y ^ + y ^ 2 ) = 2 σ 2 y 2 − 2 y . y ^ + y ^ 2 = 2 σ 2 ( y − y ^ ) 2 = 2 σ 2 D ( y , y ^ )

Poisson :f ( y ; μ ) = μ y e − μ y ! f(y;\mu) = \frac{\mu^y e^{-\mu}}{y!} f ( y ; μ ) = y ! μ y e − μ log f ( y ; μ ) = y log μ − μ − log ( y ! ) \log f(y;\mu) = y\log\mu -\mu -\log(y!) log f ( y ; μ ) = y log μ − μ − log ( y !) y ^ \hat{y} y ^ μ \mu μ log f ( y ; y ) − log f ( y ; y ^ ) = y log y y ^ − y + y ^ \log f(y;y) -\log f(y;\hat{y}) = y\log\frac{y}{\hat{y}} - y + \hat{y} log f ( y ; y ) − log f ( y ; y ^ ) = y log y ^ y − y + y ^

Binomial(sklearn 中没有) :f ( y ; n , p ) = ( n y ) p y ( 1 − p ) n − y f(y;n,p) = \binom{n}{y} p^y (1-p)^{n-y} f ( y ; n , p ) = ( y n ) p y ( 1 − p ) n − y log f ( y ; n , p ) = y log p + ( n − y ) log ( 1 − p ) + log ( ( n y ) ) \log f(y;n,p) =y\log p+(n-y)\log(1-p) + \log(\binom{n}{y}) log f ( y ; n , p ) = y log p + ( n − y ) log ( 1 − p ) + log ( ( y n ) ) y ^ \hat{y} y ^ y ^ = μ = n p \hat{y} = \mu = np y ^ = μ = n p log f ( y ; n , y n ) − log f ( y ; n , y ^ n ) = y log y y ^ + ( n − y ) log 1 − y n 1 − y ^ n = y log y y ^ + ( n − y ) log n − y n − y ^ \log f(y;n,\frac{y}{n}) - \log f(y;n,\frac{\hat{y}}{n})= y\log\frac{y}{\hat{y}} + (n-y)\log\frac{1-\frac{y}{n}}{1-\frac{\hat{y}}{n}} = y\log\frac{y}{\hat{y}} + (n-y)\log\frac{n-y}{n-\hat{y}} log f ( y ; n , n y ) − log f ( y ; n , n y ^ ) = y log y ^ y + ( n − y ) log 1 − n y ^ 1 − n y = y log y ^ y + ( n − y ) log n − y ^ n − y

上述计算都有一个 2 倍,不知道什么意思所以没有写出来。广义线性模型(GLM) 。

Logistic 函数 (Logistic function )的公式定义:

f ( x ) = L 1 + e − k ( x − x 0 ) {\displaystyle f(x)={\frac {L}{1+e^{-k(x-x_{0})}}}} f ( x ) = 1 + e − k ( x − x 0 ) L L L L x 0 x_0 x 0 K K K

逻辑斯谛分布 Logistic distribution :

分布函数 CDF(Cumulative distribution function):F ( x ; μ , s ) = 1 1 + e − ( x − μ ) / s = 1 2 + 1 2 tanh ( x − μ 2 s ) . {\displaystyle F(x;\mu ,s)={\frac {1}{1+e^{-(x-\mu )/s}}}={\frac {1}{2}}+{\frac {1}{2}}\operatorname {tanh} \left({\frac {x-\mu }{2s}}\right).} F ( x ; μ , s ) = 1 + e − ( x − μ ) / s 1 = 2 1 + 2 1 tanh ( 2 s x − μ ) .

密度函数 PDF(Probability density function):f ( x ; μ , s ) = e − ( x − μ ) / s s ( 1 + e − ( x − μ ) / s ) 2 = 1 s ( e ( x − μ ) / ( 2 s ) + e − ( x − μ ) / ( 2 s ) ) 2 = 1 4 s sech 2 ( x − μ 2 s ) . {\displaystyle {\begin{aligned}f(x;\mu ,s)&={\frac {e^{-(x-\mu )/s}}{s\left(1+e^{-(x-\mu )/s}\right)^{2}}}\\[4pt]&={\frac {1}{s\left(e^{(x-\mu )/(2s)}+e^{-(x-\mu )/(2s)}\right)^{2}}}\\[4pt]&={\frac {1}{4s}}\operatorname {sech} ^{2}\left({\frac {x-\mu }{2s}}\right).\end{aligned}}} f ( x ; μ , s ) = s ( 1 + e − ( x − μ ) / s ) 2 e − ( x − μ ) / s = s ( e ( x − μ ) / ( 2 s ) + e − ( x − μ ) / ( 2 s ) ) 2 1 = 4 s 1 sech 2 ( 2 s x − μ ) .

μ \mu μ standard deviation )成比例的参数

Sigmoid 函数 (Sigmoid function )的公式定义:S ( x ) = 1 1 + e − x = e x e x + 1 = 1 − S ( − x ) . {\displaystyle S(x)={\frac {1}{1+e^{-x}}}={\frac {e^{x}}{e^{x}+1}}=1-S(-x).} S ( x ) = 1 + e − x 1 = e x + 1 e x = 1 − S ( − x ) .

Sigmoid 函数是一个有界、可微的实函数,可以将输入压缩到(0,1)区间,经常用作激活函数和概率输出。σ ( x ) \sigma(x) σ ( x ) K = 1 , x 0 = 0 , L = 1 K=1,x_0=0,L=1 K = 1 , x 0 = 0 , L = 1

导数:S ′ ( x ) = S ( x ) ( 1 − S ( x ) ) S'(x)= S(x)(1-S(x)) S ′ ( x ) = S ( x ) ( 1 − S ( x )) S ( x ) = 1 1 + e − x = ( 1 + e − x ) − 1 S ′ ( x ) = ( − 1 ) ∗ ( 1 + e − x ) − 2 ∗ e − x ∗ ( − 1 ) = ( 1 + e − x ) − 2 ∗ e − x = e − x ( 1 + e − x ) 2 = 1 + e − x − 1 ( 1 + e − x ) 2 = 1 + e − x ( 1 + e − x ) 2 − 1 ( 1 + e − x ) 2 = 1 1 + e − x − 1 ( 1 + e − x ) 2 = 1 1 + e − x ( 1 − 1 1 + e − x ) S(x) = {\frac {1}{1+e^{-x}}} = (1+e^{-x})^{-1} \\ S'(x)=(-1)*(1+e^{-x})^{-2}*e^{-x}*(-1) \\= (1+e^{-x})^{-2}*e^{-x} \\= \frac{e^{-x}}{(1+e^{-x})^{2}} \\= \frac{1+e^{-x}-1}{(1+e^{-x})^{2}} \\= \frac{1+e^{-x}}{(1+e^{-x})^{2}} - \frac{1}{(1+e^{-x})^{2}} \\=\frac{1}{1+e^{-x}} - \frac{1}{(1+e^{-x})^{2}} \\= \frac{1}{1+e^{-x}}(1-\frac{1}{1+e^{-x}}) S ( x ) = 1 + e − x 1 = ( 1 + e − x ) − 1 S ′ ( x ) = ( − 1 ) ∗ ( 1 + e − x ) − 2 ∗ e − x ∗ ( − 1 ) = ( 1 + e − x ) − 2 ∗ e − x = ( 1 + e − x ) 2 e − x = ( 1 + e − x ) 2 1 + e − x − 1 = ( 1 + e − x ) 2 1 + e − x − ( 1 + e − x ) 2 1 = 1 + e − x 1 − ( 1 + e − x ) 2 1 = 1 + e − x 1 ( 1 − 1 + e − x 1 )

与双曲正切函数 ( hyperbolic tangent function ):f ( x ) = 1 2 + 1 2 tanh ( x 2 ) , tanh ( x ) = 2 f ( 2 x ) − 1. {\displaystyle f(x)={\frac {1}{2}}+{\frac {1}{2}}\tanh \left({\frac {x}{2}}\right),} \\ {\displaystyle \tanh(x)=2f(2x)-1.} f ( x ) = 2 1 + 2 1 tanh ( 2 x ) , tanh ( x ) = 2 f ( 2 x ) − 1.

tanh ( x ) = e x − e − x e x + e − x = e x ⋅ ( 1 − e − 2 x ) e x ⋅ ( 1 + e − 2 x ) = f ( 2 x ) − e − 2 x 1 + e − 2 x = f ( 2 x ) − e − 2 x + 1 − 1 1 + e − 2 x = 2 f ( 2 x ) − 1. {\displaystyle {\begin{aligned}\tanh(x)&={\frac {e^{x}-e^{-x}}{e^{x}+e^{-x}}}={\frac {e^{x}\cdot \left(1-e^{-2x}\right)}{e^{x}\cdot \left(1+e^{-2x}\right)}}\\&=f(2x)-{\frac {e^{-2x}}{1+e^{-2x}}}=f(2x)-{\frac {e^{-2x}+1-1}{1+e^{-2x}}}=2f(2x)-1.\end{aligned}}} tanh ( x ) = e x + e − x e x − e − x = e x ⋅ ( 1 + e − 2 x ) e x ⋅ ( 1 − e − 2 x ) = f ( 2 x ) − 1 + e − 2 x e − 2 x = f ( 2 x ) − 1 + e − 2 x e − 2 x + 1 − 1 = 2 f ( 2 x ) − 1.

Softmax 函数 (Softmax function ,也称为归一化指数函数 normalized exponential function)的公式定义:σ : R K → [ 0 , 1 ] K {\displaystyle \sigma :\mathbb {R} ^{K}\to [0,1]^{K}} σ : R K → [ 0 , 1 ] K

σ ( z ) i = e z i ∑ j = 1 K e z j for i = 1 , … , K and z = ( z 1 , … , z K ) ∈ R K . {\displaystyle \sigma (\mathbf {z} )_{i}={\frac {e^{z_{i}}}{\sum _{j=1}^{K}e^{z_{j}}}}\ \ \ \ {\text{ for }}i=1,\dotsc ,K{\text{ and }}\mathbf {z} =(z_{1},\dotsc ,z_{K})\in \mathbb {R} ^{K}.} σ ( z ) i = ∑ j = 1 K e z j e z i for i = 1 , … , K and z = ( z 1 , … , z K ) ∈ R K .

一般形式:σ ( z ) i = e β z i ∑ j = 1 K e β z j or σ ( z ) i = e − β z i ∑ j = 1 K e − β z j for i = 1 , … , K . {\displaystyle \sigma (\mathbf {z} )_{i}={\frac {e^{\beta z_{i}}}{\sum _{j=1}^{K}e^{\beta z_{j}}}}{\text{ or }}\sigma (\mathbf {z} )_{i}={\frac {e^{-\beta z_{i}}}{\sum _{j=1}^{K}e^{-\beta z_{j}}}}{\text{ for }}i=1,\dotsc ,K.} σ ( z ) i = ∑ j = 1 K e β z j e β z i or σ ( z ) i = ∑ j = 1 K e − β z j e − β z i for i = 1 , … , K .

性质:σ ( z + c ) j = e z j + c ∑ k = 1 K e z k + c = e z j ⋅ e c ∑ k = 1 K e z k ⋅ e c = σ ( z ) j . {\displaystyle \sigma (\mathbf {z} +\mathbf {c} )_{j}={\frac {e^{z_{j}+c}}{\sum _{k=1}^{K}e^{z_{k}+c}}}={\frac {e^{z_{j}}\cdot e^{c}}{\sum _{k=1}^{K}e^{z_{k}}\cdot e^{c}}}=\sigma (\mathbf {z} )_{j}.} σ ( z + c ) j = ∑ k = 1 K e z k + c e z j + c = ∑ k = 1 K e z k ⋅ e c e z j ⋅ e c = σ ( z ) j .

等式左边的c = ( c , … , c ) {\displaystyle \mathbf {c} =(c,\dots ,c)} c = ( c , … , c )

如果z i z_i z i ( 1 K , . . . , 1 K ) ∈ R K (\frac{1}{K},...,\frac{1}{K}) \in \mathbb{R}^K ( K 1 , ... , K 1 ) ∈ R K e C e^C e C ∑ k = 1 K e C \sum _{k=1}^{K}e^C ∑ k = 1 K e C z \mathbf {z} z max i z i \max_i {z_i} max i z i σ ( z ) i = e z i ∑ j = 1 K e z j = e ( z i − z m a x ) ∑ j = 1 K e ( z j − z m a x ) = e ( z i − z m a x ) 1 + ∑ j = 1 , j ≠ m a x K e ( z j − z m a x ) \sigma (\mathbf {z} )_{i}={\frac {e^{z_{i}}}{\sum _{j=1}^{K}e^{z_{j}}}} = {\frac {e^{(z_{i}-z_{max})}}{\sum _{j=1}^{K}e^{(z_{j}-z_{max})}}} = {\frac {e^{(z_{i}-z_{max})}}{1+\sum _{j=1,j\neq max}^{K}e^{(z_{j}-z_{max})}}} σ ( z ) i = ∑ j = 1 K e z j e z i = ∑ j = 1 K e ( z j − z ma x ) e ( z i − z ma x ) = 1 + ∑ j = 1 , j = ma x K e ( z j − z ma x ) e ( z i − z ma x )

log softmax 函数在深度学习中也经常遇见,其实就是求完 softmax,再对其求 log,如果直接计算可能会出现问题(当 softmax 很小时,log 会得到− ∞ -\infty − ∞ log ( σ ( z ) ) i = log e ( z i − z m a x ) ∑ j = 1 K e ( z j − z m a x ) = log e ( z i − z m a x ) − log ∑ j = 1 K e ( z j − z m a x ) = ( z i − z m a x ) − log ∑ j = 1 K e ( z j − z m a x ) \log(\sigma (\mathbf {z} ))_{i}=\log{\frac {e^{(z_{i}-z_{max})}}{\sum _{j=1}^{K}e^{(z_{j}-z_{max})}}} \\= \log e^{(z_{i}-z_{max})} - \log {\sum _{j=1}^{K}e^{(z_{j}-z_{max})}} \\= (z_{i}-z_{max})- \log {\sum _{j=1}^{K}e^{(z_{j}-z_{max})}} log ( σ ( z ) ) i = log ∑ j = 1 K e ( z j − z ma x ) e ( z i − z ma x ) = log e ( z i − z ma x ) − log j = 1 ∑ K e ( z j − z ma x ) = ( z i − z ma x ) − log j = 1 ∑ K e ( z j − z ma x )

而∑ j = 1 K e ( z j − z m a x ) {\sum _{j=1}^{K}e^{(z_{j}-z_{max})}} ∑ j = 1 K e ( z j − z ma x )

negative log-likelihood (NLL),likelihood 是一个概率(softmax 也是概率),所以 log-likelihood 小于 0,negative log-likelihood 则大于 0,这样就可以最小化 negative log-likelihood 了

[6-1] Berger A,Della Pietra SD,Pietra VD. A maximum entropy approach to naturallanguage processing. Computational Linguistics,1996,22(1),39–71

[6-2] Berger A. The Improved Iterative Scaling Algorithm: A Gentle Introduction.http://www.cs.cmu.edu/ afs/cs/user/aberger/www/ps/scaling.ps

[6-3] Hastie T,Tibshirani R,Friedman J. The Elements of Statistical Learning: DataMining,Inference,and Prediction. Springer-Verlag. 2001(中译本:统计学习基础——数据挖掘、推理与预测。范明,柴玉梅,昝红英等译。北京:电子工业出版社,2004)

[6-4] Mitchell TM. Machine Learning. McGraw-Hill Companies,Inc. 1997(中译本:机器学习。北京:机械工业出版社,2003)

[6-5] Collins M,Schapire RE,Singer Y. Logistic Regression,AdaBoost and BregmanDistances. Machine Learning Journal,2004

[6-6] Canu S,Smola AJ. Kernel method and exponential family. Neurocomputing,2005,69:714–720

支持向量机 (support vector machine,SVM )是一种二类分类模型。它的基本模型是定义在特征空间上的间隔最大的线性分类器,间隔最大使它有别于感知机;支持向量机还包括核技巧 ,这使它成为实质上的非线性分类器。支持向量机的学习策略就是间隔最大化,可形式化为一个求解凸二次规划 (convex quadratic programming)的问题,也等价于正则化的合页损失函数 的最小化问题。支持向量机的学习算法是求解凸二次规划的最优化算法。

支持向量机学习方法包含构建由简至繁的模型:线性可分支持向量机 (linear supportvector machine in linearly separable case)、线性支持向量机 (linear support vectormachine)及非线性支持向量机 (non-linear support vector machine)。简单模型是复杂模型的基础,也是复杂模型的特殊情况。当训练数据线性可分时,通过硬间隔最大化 (hardmargin maximization),学习一个线性的分类器,即线性可分支持向量机,又称为硬间隔支持向量机 ;当训练数据近似线性可分时,通过软间隔最大化 (soft marginmaximization),也学习一个线性的分类器,即线性支持向量机,又称为软间隔支持向量机 ;当训练数据线性不可分时,通过使用核技巧(kernel trick)及软间隔最大化,学习非线性支持向量机 。

当输入空间为欧氏空间或离散集合、特征空间为希尔伯特空间时,核函数(kernelfunction)表示将输入从输入空间映射到特征空间得到的特征向量之间的内积。通过使用核函数可以学习非线性支持向量机,等价于隐式地在高维的特征空间中学习线性支持向量机。这样的方法称为核技巧。核方法(kernel method)是比支持向量机更为一般的机器学习方法。

SVM 有三宝:间隔、对偶、核技巧

函数间隔:γ ^ = y ( w . x + b ) , y ∈ { − 1 , + 1 } \hat\gamma = y(w.x + b), y\in \{-1,+1\} γ ^ = y ( w . x + b ) , y ∈ { − 1 , + 1 } γ = 1 ∥ w ∥ ∣ w . x + b ∣ = γ ^ ∥ w ∥ \gamma = \frac{1}{\|w\|}|w.x + b| = \frac{\hat\gamma}{\|w\|} γ = ∥ w ∥ 1 ∣ w . x + b ∣ = ∥ w ∥ γ ^

w . x + b = 0 w.x + b=0 w . x + b = 0

最大间隔(硬间隔原始问题-凸二次规划)max w , b γ ^ ∥ w ∥ s.t. y i ( w . x i + b ) ≥ γ ^ \begin{aligned} &\max_{w,b} &\frac{\hat\gamma}{\|w\|} \\ &\text{s.t.} &y_i(w.x_i+b) \geq \hat\gamma\end{aligned} w , b max s.t. ∥ w ∥ γ ^ y i ( w . x i + b ) ≥ γ ^ γ ^ \hat\gamma γ ^ min w , b 1 2 ∥ w ∥ 2 s.t. y i ( w . x i + b ) ≥ 1 \begin{aligned} &\min_{w,b} &\frac{1}{2}\|w\|^2 \\ &\text{s.t.} &y_i(w.x_i+b) \geq 1\end{aligned} w , b min s.t. 2 1 ∥ w ∥ 2 y i ( w . x i + b ) ≥ 1 1 ∥ w ∥ \frac{1}{\|w\|} ∥ w ∥ 1 ∥ w ∥ = 0 \|w\| = 0 ∥ w ∥ = 0 arg max 1 ∥ w ∥ 与 arg min 1 2 ∥ w ∥ 2 \argmax \frac{1}{\|w\|} 与 \argmin \frac{1}{2}\|w\|^2 arg max ∥ w ∥ 1 与 arg min 2 1 ∥ w ∥ 2 存在且唯一 ,具体证明就不证了(见统计学习方法 117 页)。支持向量 ,也就是满足y i ( w . x i + b ) = 1 y_i(w.x_i +b ) =1 y i ( w . x i + b ) = 1 w . x i + b = + 1 , w . x i + b = − 1 w.x_i +b = +1,w.x_i +b = -1 w . x i + b = + 1 , w . x i + b = − 1 间隔边界 ,两个间隔边界之间的距离称为间隔 (margin),间隔大小为2 ∥ w ∥ \frac{2}{\|w\|} ∥ w ∥ 2 只有支持向量起作用 ,而其它样本点并不起作用,所以该模型叫做支持向量机。

拉格朗日函数(求最小)L ( w , b , α ) = 1 2 ∥ w ∥ 2 + ∑ i = 1 N α i ( 1 − y i ( w . x i + b ) ) L(w,b,\alpha) = \frac{1}{2}\|w\|^2 + \sum_{i=1}^N \alpha_i(1-y_i(w.x_i+b)) L ( w , b , α ) = 2 1 ∥ w ∥ 2 + i = 1 ∑ N α i ( 1 − y i ( w . x i + b )) min w , b max α L ( w , b , α ) \min_{w,b} \max_{\alpha} L(w,b,\alpha) w , b min α max L ( w , b , α )

拉格朗日对偶函数(求最大)max α g ( α ) = max α inf w , b L ( w , b , α ) \max_{\alpha} g(\alpha) = \max_{\alpha} \inf_{w,b} L(w,b,\alpha) α max g ( α ) = α max w , b inf L ( w , b , α )

带正则项的合页损失函数(软间隔原始问题-凸二次规划)min w , b ∑ i = 1 N max ( 0 , 1 − y i ( w . x i + b ) ) ⏟ hinge loss function + λ ∥ w ∥ 2 ⏟ 正则化项 \min_{w,b} \underbrace{\sum_{i=1}^N\max(0,1-y_i(w.x_i+b))}_{\text{hinge loss function}} + \underbrace{\lambda\|w\|^2}_{\text{正则化项}} w , b min hinge loss function i = 1 ∑ N max ( 0 , 1 − y i ( w . x i + b )) + 正则化项 λ ∥ w ∥ 2 软间隔 最大化的优化问题:min w , b , ξ ∑ i = 1 n ξ i + λ ∥ w ∥ 2 subject to y i ( w T x i + b ) ≥ 1 − ξ i ξ i ≥ 0 , for all i . \begin{aligned} &\min_{w,b,\xi} & \sum _{i=1}^{n}\xi _{i}+\lambda \|\mathbf {w} \|^{2} \\ &\displaystyle {\text{subject to }} & y_{i}(\mathbf {w} ^{T}\mathbf {x} _{i}+b)\geq 1-\xi _{i}\\ &&\xi _{i}\geq 0,\,{\text{for all }}i.\end{aligned} w , b , ξ min subject to i = 1 ∑ n ξ i + λ ∥ w ∥ 2 y i ( w T x i + b ) ≥ 1 − ξ i ξ i ≥ 0 , for all i . ξ i = max ( 0 , 1 − y i ( w T x i + b ) ) {\displaystyle \xi _{i}=\max \left(0,1-y_{i}(\mathbf {w} ^{T}\mathbf {x} _{i}+b)\right)} ξ i = max ( 0 , 1 − y i ( w T x i + b ) ) Relaxation 有很多,下面只是一种而已)(跟下面松弛变量定义不同,只有统计学习方法中有说到,其它地方没有找到)。y i ( w T x i + b ) ≥ 1 − ξ i y_{i}(\mathbf {w} ^{T}\mathbf {x} _{i}+b)\geq 1-\xi _{i} y i ( w T x i + b ) ≥ 1 − ξ i

拉格朗日函数(求最小)L ( w , b , ξ , α , μ ) = λ ∥ w ∥ 2 + ∑ i = 1 N ξ i + ∑ i = 1 N α i ( 1 − ξ i − y i ( w . x i + b ) ) + ∑ i = 1 N ( μ i ∗ ( − ξ i ) ) L(w,b,\xi,\alpha,\mu) = \lambda\|w\|^2 + \sum_{i=1}^N \xi_{i} + \sum_{i=1}^N \alpha_i(1-\xi_{i}-y_i(w.x_i+b)) + \sum_{i=1}^N(\mu_i*(-\xi_{i})) L ( w , b , ξ , α , μ ) = λ ∥ w ∥ 2 + i = 1 ∑ N ξ i + i = 1 ∑ N α i ( 1 − ξ i − y i ( w . x i + b )) + i = 1 ∑ N ( μ i ∗ ( − ξ i )) min w , b , ξ max α , μ L ( w , b , ξ , α , μ ) \min_{w,b,\xi} \max_{\alpha,\mu} L(w,b,\xi,\alpha,\mu) w , b , ξ min α , μ max L ( w , b , ξ , α , μ )

拉格朗日对偶函数(求最大)max α , μ g ( α , μ ) = max α , μ inf w , b , ξ L ( w , b , ξ , α , μ ) \max_{\alpha,\mu} g(\alpha,\mu) = \max_{\alpha,\mu} \inf_{w,b,\xi} L(w,b,\xi,\alpha,\mu) α , μ max g ( α , μ ) = α , μ max w , b , ξ inf L ( w , b , ξ , α , μ )

算法 :

核技巧 :x 用 ϕ ( x ) x用\phi (x) x 用 ϕ ( x ) ϕ ( x ) \phi (x) ϕ ( x )

书中还介绍了原形式的对偶形式 (区别于拉格朗日对偶),也就是等价形式(感知机中 2.3.3 节 44 页 也是等价的意思),这两个地方的等价都是经过基本推导,求出 w 参数,然后对原问题进行了替换。

最优化:建模、算法与理论/最优化计算方法 Stephen Boyd 的 Convex Optimization - 凸优化 Nonlinear Programming by Dimitri P. Bertsekas - 非线性规划

凸优化 (Convex optimization ):minimize x f ( x ) subject to g i ( x ) ≤ 0 , i = 1 , … , m h i ( x ) = 0 , i = 1 , … , p , {\displaystyle {\begin{aligned}&{\underset {\mathbf {x} }{\operatorname {minimize} }}&&f(\mathbf {x} )\\&\operatorname {subject\ to} &&g_{i}(\mathbf {x} )\leq 0,\quad i=1,\dots ,m\\&&&h_{i}(\mathbf {x} )=0,\quad i=1,\dots ,p,\end{aligned}}} x minimize subject to f ( x ) g i ( x ) ≤ 0 , i = 1 , … , m h i ( x ) = 0 , i = 1 , … , p , x ∈ R n \mathbf {x} \in \mathbb {R} ^{n} x ∈ R n 目标函数 (objective function)f : D ⊆ R n → R {\displaystyle f:{\mathcal {D}}\subseteq \mathbb {R} ^{n}\to \mathbb {R} } f : D ⊆ R n → R 不等式约束 g i : R n → R {\displaystyle g_{i}:\mathbb {R} ^{n}\to \mathbb {R} } g i : R n → R 等式约束 h i : R n → R {\displaystyle h_{i}:\mathbb {R} ^{n}\to \mathbb {R} } h i : R n → R 仿射 (affine )的

二次约束二次规划 (Quadratically constrained quadratic program ):minimize 1 2 x T P 0 x + q 0 T x subject to 1 2 x T P i x + q i T x + r i ≤ 0 for i = 1 , … , m , A x = b , {\begin{aligned}&{\text{minimize}}&&{\tfrac 12}x^{{\mathrm {T}}}P_{0}x+q_{0}^{{\mathrm {T}}}x\\&{\text{subject to}}&&{\tfrac 12}x^{{\mathrm {T}}}P_{i}x+q_{i}^{{\mathrm {T}}}x+r_{i}\leq 0\quad {\text{for }}i=1,\dots ,m,\\&&&Ax=b,\end{aligned}} minimize subject to 2 1 x T P 0 x + q 0 T x 2 1 x T P i x + q i T x + r i ≤ 0 for i = 1 , … , m , A x = b , P 0 以及 P 1 , . . , P m ∈ R n × n P_0以及P_1,..,P_m \in \mathbb{R}^{n \times n} P 0 以及 P 1 , .. , P m ∈ R n × n x ∈ R n \mathbf {x} \in \mathbb {R} ^{n} x ∈ R n P 0 以及 P 1 , . . , P m ∈ R n × n P_0以及P_1,..,P_m \in \mathbb{R}^{n \times n} P 0 以及 P 1 , .. , P m ∈ R n × n P 1 , . . , P m P_1,..,P_m P 1 , .. , P m 二次规划 (Quadratic programming ),即目标函数是二次的,不等式以及等式约束也是线性的;二次规划的前提下,如果P 0 P_0 P 0 凸二次规划 ;如果P 0 P_0 P 0 不标准的线性规划 (Linear programming ),即目标函数是线性的,不等式以及等式约束也是线性的。标准的线性规划 :即目标函数是线性的,非负约束(优化变量是非负的),等式约束也是线性的。

线性规划解法有单纯形法 等。其它规划的优化算法看这里 :内点法,单纯形法等;有线性规划自然也有动态规划 (Dynamic programming )

最小二乘不就是凸二次规划么 (∥ y − f ( x ) ∥ 2 , f ( x ) = A x + c \|y-f(x)\|^2,f(x) = Ax+c ∥ y − f ( x ) ∥ 2 , f ( x ) = A x + c minimize f ( x ) = 1 2 ∥ A x − b ∥ 2 = 1 2 ( A x − b ) T ( A x − b ) = 1 2 ( x T A T A x − x T A T b − b T A x + b t b ) = 1 2 ( x T A T A x − 2 x T A T b + b t b ) \text{minimize} f(x) =\frac{1}{2} \|Ax-b\|^2 = \frac{1}{2}(Ax-b)^T(Ax-b) \\= \frac{1}{2}(x^TA^TAx - x^TA^Tb -b^TAx + b^tb) \\= \frac{1}{2}(x^TA^TAx - 2x^TA^Tb + b^tb) minimize f ( x ) = 2 1 ∥ A x − b ∥ 2 = 2 1 ( A x − b ) T ( A x − b ) = 2 1 ( x T A T A x − x T A T b − b T A x + b t b ) = 2 1 ( x T A T A x − 2 x T A T b + b t b ) A ∈ R m × n , x ∈ R n × 1 , b ∈ R m × 1 A \in \mathbb{R}^{m \times n},x \in \mathbb{R}^{n \times 1},b \in \mathbb{R}^{m \times 1} A ∈ R m × n , x ∈ R n × 1 , b ∈ R m × 1 x T A T b 和 b T A x x^TA^Tb 和 b^TAx x T A T b 和 b T A x b t b b^tb b t b A T A A^TA A T A

L1 和 L2 回归也能转化称相应的优化问题 ,参考:L1L2 正则化和凸优化

共轭函数 (conjugate function ):f : R n → R f:\mathbb{R}^n \to \mathbb{R} f : R n → R f ∗ : R n → R f^*:\mathbb{R}^n \to \mathbb{R} f ∗ : R n → R f ∗ ( y ) = sup x ∈ d o m f ( y T x − f ( x ) ) f^*(y) = \sup_{x \in \mathrm{dom} f} (y^Tx - f(x)) f ∗ ( y ) = x ∈ dom f sup ( y T x − f ( x ))

拉格朗日乘数法 (Lagrange multiplier ):L ( x , λ , ν ) = f ( x ) + ∑ i = 1 m λ i g i ( x ) + ∑ i = 1 p ν i h i ( x ) L(x,\lambda,\nu) = f(x) +\sum _{i=1}^{m}\lambda _{i}g_{i}(x)+\sum _{ i=1}^{p}\nu _{i}h_{i}(x) L ( x , λ , ν ) = f ( x ) + i = 1 ∑ m λ i g i ( x ) + i = 1 ∑ p ν i h i ( x ) λ i , ν i \lambda _{i},\nu _{i} λ i , ν i λ , ν \lambda,\nu λ , ν Lagrange 乘子向量 或对偶变量 。